L'apprentissage par renforcement hiérarchique (HRL, pour Hierarchical Reinforcement Learning) est une approche avancée de l'apprentissage par renforcement (RL) qui structure le processus de décision en différents niveaux d'abstraction. Cette méthodologie vise à décomposer des tâches complexes en sous-tâches plus simples, chacune pouvant être résolue par des sous-agents ou des politiques spécialisées. Contrairement au RL classique, où l'agent apprend une politique unique pour toute la tâche, le HRL permet un apprentissage structuré et modulaire, facilitant la généralisation et la réutilisation des compétences apprises.

Cas d'usages et exemples d'utilisation

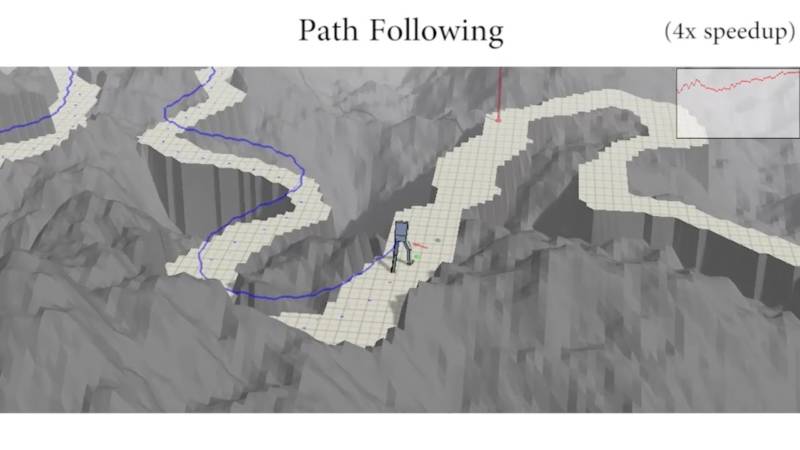

Le HRL est particulièrement adapté aux problèmes où une tâche globale peut être naturellement divisée en étapes ou en compétences distinctes, comme la robotique (navigation, manipulation d'objets), la planification de missions complexes, les jeux vidéo à plusieurs niveaux, et la gestion d'opérations industrielles. Par exemple, dans la robotique, un agent peut apprendre à « naviguer dans une pièce » en combinant des sous-politiques telles que « ouvrir une porte » ou « éviter un obstacle ».

Dans le domaine du traitement du langage naturel, le HRL peut être utilisé pour structurer des dialogues complexes ou pour orchestrer des tâches de génération de texte en plusieurs phases. Dans les jeux, il permet de gérer des stratégies à long terme tout en optimisant les réactions à court terme.

Principaux outils logiciels, librairies, frameworks, logiciels

Parmi les outils couramment utilisés pour le HRL, on retrouve TensorFlow Agents, PyTorch RL et OpenAI Baselines, qui offrent des modules facilitant l'implémentation de politiques hiérarchiques. Des bibliothèques spécialisées comme Stable Baselines3 ou RLlib de Ray proposent également des extensions ou des exemples pour le HRL.

Certains environnements de simulation, tels que OpenAI Gym et Unity ML-Agents, proposent des benchmarks adaptés à la recherche en HRL, favorisant l'expérimentation et la comparaison de différentes architectures hiérarchiques.

Derniers développements, évolutions et tendances

Le HRL connaît un regain d'intérêt grâce aux récents progrès dans les architectures modulaires, l'apprentissage par transfert et le meta-learning. Les recherches portent sur l'automatisation de la découverte de sous-tâches, la robustesse des politiques hiérarchiques et l'intégration avec des modèles génératifs.

Les tendances actuelles incluent l'application du HRL à des environnements multi-agents, l'utilisation de modèles de langage pour guider la hiérarchisation des tâches, et l'optimisation de l'efficacité de l'apprentissage grâce à des approches hybrides combinant HRL et apprentissage par imitation.