Depuis la maîtrise du feu jusqu’à celle de l’atome en passant par l’imprimerie et la machine à vapeur, chaque progrès technologique de l’humanité a entraîné à la fois de l’espoir et de l’inquiétude. On remarque que les dérives (discriminations, excès de pouvoir, inégalités, etc.) des Nouvelles technologies de l’information et la communication (NTIC) qui nous inquiètent tant ne sont que l’expression et la traduction des dérives qui se sont perpétuées depuis la nuit des temps dans les civilisations humaines. On peut se dire que les innovations technologiques ont la valeur morale que nous leur attribuons par l’usage que nous en faisons. Chaque révolution industrielle entraîne une révolution humaniste marquant généralement un tournant de civilisation et une refonte du modèle sociétal. Si le système socio-économique ne répond plus aux exigences de survie de l’humanité dans cet environnement de plus en plus digital, alors il nous faut réinventer et construire un projet de société fondé sur un autre système. Cette quatrième révolution industrielle – basée sur les données numériques et l’Intelligence Artificielle (IA) – n’est pas du tout comme ses précédentes, avec un pouvoir de rupture incomparable. Nous sommes en plein dans un moment d’incertitude, de confusion et de basculement où l’humanité n’arrive plus à se projeter dans le futur comme lorsque la mer et le ciel se confondent à ne plus en distinguer la ligne d’horizon. Pour la première fois dans l’histoire de l’homme, c’est le futur de l’humanité comme on la connaît qui se joue à travers les lignes de code des machines intelligentes. Le rythme des innovations technologiques et la temporalité de leur déploiement mondial soutenue par l’économie digitale dépassent très nettement la vitesse de la prise de conscience humaine. Dans ces conditions, il est grand temps de concevoir et structurer une éthique du numérique et en particulier relative à l’IA.

Aujourd’hui, la société n’a pas établi véritablement de règles ou de directives universelles afin d’aider à intégrer les normes morales ou de valeurs humaines que l’humanité véhicule dans l’IA. Les initiatives publiques ou privées sur l’encadrement éthique des applications numériques se multiplient, l’une des dernières en date étant le projet de réglementations d’une IA de confiance présenté par la Commission européenne en avril 2021. Ainsi, avec la croissance exponentielle du digital, il devient désormais urgent de trouver un consensus autour d’un socle éthique universel afin de pouvoir communiquer et expliquer, dans un souci de transparence, les actions des systèmes intelligents autonomes. L’enjeu est d’acquérir un degré de confiance optimal compte tenu des scénarii dans lesquels l’être humain les utilise.

Dans ce contexte, les responsables d’applications de l’IA doivent intégrer, dès leur conception, les enjeux et les risques qu’elles font porter à la société civile. Afin de tenter de répondre à cela, nous avons identifié deux démarches, non exclusives, qui peuvent être différenciées :

- L’IA éthique ou morale : cette approche modélise et programme des éléments provenant de l’éthique dans une application intelligente, en réfléchissant aux moyens d’allouer les machines de principes et règles éthiques ou d’un processus de résolution des problèmes éthiques qu’elles peuvent rencontrer afin de devenir éthiquement responsable sur le fondement d’un système de décision éthique propre ;

- L’IA digne de confiance : cette démarche considère moins l’éthique comme l’intégration de réflexions éthiques au sein du code qu’a doté ce dernier de propriétés et concepts généraux permettant de contrôler la conformité des décisions automatiques avec les valeurs sur lesquelles s’accordent le groupe social qui y recourt.

Dans cette tribune, nous sommes plus partisans de la première démarche qui nous paraît beaucoup plus prometteuse, évolutive et pérenne dans le temps. Elle s’intègre parfaitement dans notre approche de l’Ethics by Design(1) puis de l’Ethics by Evolution(2) que nous souhaitons mettre en place dans les IA.

En raison des complexités conceptuelles relatives aux « valeurs » et « principes » moraux, il est difficile d’envisager et d’appréhender des structures de calcul correspondant directement à des valeurs humaines universelles. Cependant, si nous associons des normes et des règles éthiques à ces principes universels, on peut plus facilement imaginer intégrer des normes éthiques explicites dans de telles IA. En effet, ces règles éthiques peuvent être identifiées comme étant des instructions pragmatiques d’agir de manière définie dans des contextes définis. On peut alors parler de décodage et d’encodage éthique de l’IA. La conception des techniques d’IA devra impérativement embarquer l’éthique. Selon la vision d’Asimov, il est primordial d’intégrer de l’éthique dans la technologie, c’est-à-dire la prise en considération en amont, par anticipation, de dilemmes et des problématiques d’ordre éthique qui pourraient aller à l’encontre des trajectoires d’innovations espérées. Cela revient d’abord, pour les utilisateurs, d’obtenir un consensus sur des principes éthiques communs, puis à les encoder dans les applications d’IA, en vue de s’assurer que les médiations qu’elles réalisent les respectent.

Une fois les principes et les règles éthiques reconnus, il faudra les incorporer dans la technologie d’IA de façon à ce que leurs comportements leurs soient conformes. De manière plus générale, les NTIC doivent également satisfaire les valeurs sur lesquelles les sociétés y recourent. Ces IA font ainsi l’objet d’une vigilance renforcée en raison de spécificités majeures, l’autonomie décisionnelle et l’apprentissage qui impactent trois enjeux sociaux fondamentaux : la transparence, la sécurité et la responsabilité.

L’enjeu est de concevoir des algorithmes capables de fonctionner dans des situations impliquant des considérations éthiques. Cela génère deux familles de risques : d’une part, les risques rattachés à des défauts de conception, et d’autre part, les risques associés à l’apprentissage.

Ainsi, apporter du sens à l’IA met en lumière trois angles de vue :

- l’orientation indique la politique et la stratégie relative à l’IA ;

- la signification révèle la dimension sociétale de l’IA, qui ne doit pas être une finalité, mais un outil au service de la société entraînant : la complémentarité entre les êtres humains et les systèmes intelligents, l’explicabilité des systèmes algorithmiques et le développement d’une IA inclusive ;

- les explications concernent une réflexion collective sur les objectifs poursuivis et leurs bien-fondés.

La mise en place d’un tel système de normes éthiques n’est pas simple à mettre en place, et suscite quelques questionnements obligatoires.

Dans ces conditions, nous préconisons :

- dans un premier temps, une démarche inclusive des parties prenantes dès l’élaboration de l’IA (conception) afin d’apporter des signaux transparents (capacité d’inspection et/ou d’explication) sur la nature de leur finalité et leur comportement vis-à-vis des acteurs de la société : c’est l’Ethics by Design ;

- dans un second temps, élargir cette approche durant tout le long du cycle de développement et de vie de l’IA (mise en place et usage), en faisant évoluer les critères et métriques éthiques au fur et à mesure de l’apprentissage et de l’évolution de la machine : c’est ce que nous appelons l’Ethics by Evolution.

Ainsi, cette méthode d’inclusion éthique proactive des utilisateurs et leur interaction avec l’IA auront pour conséquence d’augmenter, dans le temps, la confiance et la fiabilité d’ensemble des systèmes algorithmiques.

Par ailleurs, alors que les algorithmes soient dernièrement pointés du doigt comme étant discriminants, sexistes, biaisés, nous sommes en droit de nous demander où plaçons-nous la véritable responsabilité de ces constats ? L’algorithme n’est qu’un instrument qui sans les données qu’on lui ingère et l’humain qui la développe puis l’utilise ne présente qu’un faible danger. Et si nous prenions du recul et de hauteur sur nos développements et nos projets d’IA peut-être qu’avec un peu d’encadrement nous pourrions mieux appréhender puis anticiper ce nouveau « virus » qui guette nos modèles algorithmiques : les Biais !

Qu’ils soient de nature cognitive, statistique (liée aux données, aux variables omises, à la sélection, à l’endogénéité), et économique, ces biais implicites ou explicites peuvent contribuer à rendre une IA sexiste, discriminante, voire malveillante. Cela révèle alors une faille que la révolution digitale n’avait pas vu venir : tendons-nous réellement vers une humanité digitale ?

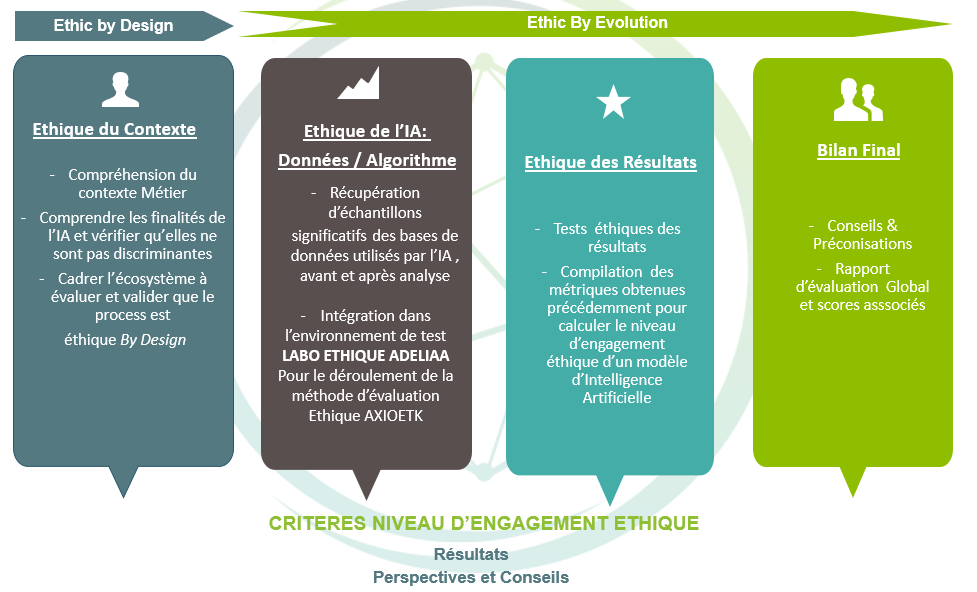

Dès lors, n’est-il pas nécessaire d’accompagner et d’acculturer les data scientists vers une démarche de développement responsable et d’Intelligence émotionnelle et donc plus humaine. C’est pour répondre à ce constat et problématique que la méthode AXIOETK(3) a été pensée et élaborée, avec cette conscience de remettre l’humain au cœur de la technologie en évaluant les étapes du cycle de vie de l’algorithme et testant le niveau d’engagement éthique des modèles algorithmiques. (Voir figure ci-dessous)

Plusieurs axes sont alors abordés et questionnements posés : l’éthique du contexte – dans quel contexte, quel cadre et avec quelles finalités les algorithmes ont-ils été créés ? Par qui ? Et le plus important sur quelles données ? Est-ce que la représentativité sociale (diversité, mixité, inclusion, …) a été prise en compte dans les données d’apprentissage ? Est-ce que les développeurs ont été sensibilisés aux enjeux sociétaux d’un IA révélatrice de biais ? Toutes ces interrogations peuvent être abordées dans une premier phase d’éthique du contexte afin d’apporter un cadre et une acculturation éthique au projet d’IA évalué. L’enjeu étant de concevoir des algorithmes capables de fonctionner dans des situations impliquant des considérations éthiques afin de donner du sens et de la confiance à notre IA. La seconde phase, est davantage apparentée à une expérimentation en laboratoire lors de laquelle seraient testées les données en entrée et en sortie d’un système algorithmique intégré dans une application d’IA afin de mesurer son niveau d’engagement éthique algorithmique via des métriques telles que : la Fiabilité, l’Interprétabilité, la Qualité & Robustesse, et la Discrimination, l’égalité des chances et des opportunités, …

Puis y succède en phase finale l’Ethique des Résultats afin de suivre de bout en bout dans sa conception mais également dans son utilisation un algorithme et d’en pressentir son niveau d’engagement éthique. Notre vision est d’élargir cette approche durant tout le long du cycle de développement de l’IA (mise en place et usage), en faisant évoluer les critères et métriques éthiques au fur et à mesure de l’apprentissage et de l’évolution de la machine en interaction avec son environnement et écosystème ambiant : c’est l’Ethics by Evolution.

L’idée serait également de reprendre le contrôle humain par la volonté d’atténuer et corriger les biais tout le long du cycle de vie de l’algorithme, en ajustant notamment les pondérations et les seuils de tolérances et d’acceptation : c’est l’Ethics by Correction.

Ainsi, cette méthode d’inclusion éthique proactive et corrective des utilisateurs et leur interaction avec l’IA aura pour conséquence d’augmenter, dans le temps, la confiance et le bienfondé d’ensemble des systèmes algorithmiques.

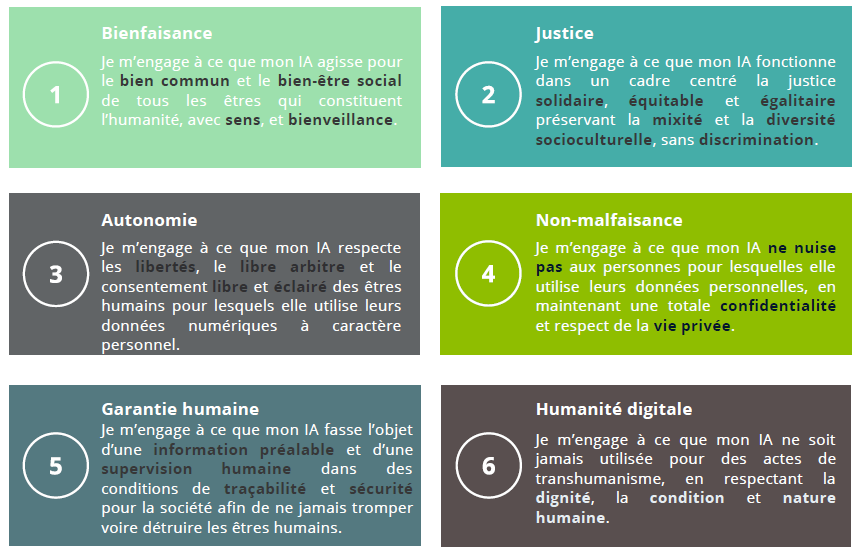

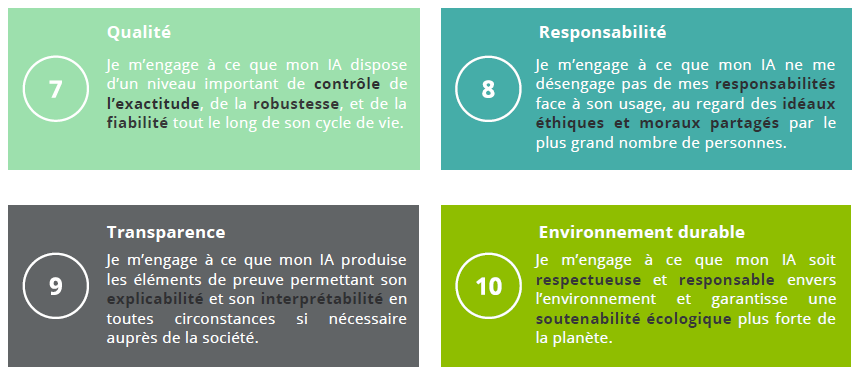

C’est dans ce contexte que nous avons a pu aboutir entre autres à l’élaboration et la rédaction d’un manifeste pour une IA Ethique et Responsable composé de 10 principes majeurs associés chacun à un engagement fort. Ce document s’adresse à toutes les parties prenantes (organisations, territoires, … et citoyens) impliquées dans le développement, le déploiement, l’usage ou l’accompagnement d’une IA. Ce document est un élément fondateur pour constituer une véritable communauté « Digital Ethics » autour d’une IA digne de confiance : #VersuneIAEthique&Responsable (Voir figure ci-dessous)

Manifeste vers une IA Ethique et Responsable(4)

En définitif, l’IA est porteuse de grandes promesses, mais également de fortes angoisses, d’aléas et de dangers qu’il convient de corriger, voire de supprimer, afin d’en garantir un déploiement conforme au cadre légal, à des valeurs morales et principes éthiques, et au bien commun. Ainsi, même si aujourd’hui, des préconisations éthiques impactent faiblement le périmètre fonctionnel d’une IA et qu’elles introduisent un niveau de complexité supplémentaire dans la conception des systèmes autoapprenants, il devient primordial, à l’avenir, de concevoir et d’intégrer des critères éthiques pour développer une véritable une culture de l’éthique autour des projets digitaux relatifs à l’IA.

L’objectif final est d’apporter une garantie de sécurité, du sens, de la confiance et de la transparence autour du traitement des données numériques au sein des organisations, des entreprises, des institutions, et des territoires.

1- Approche qui intègre des exigences et des préconisations éthiques dès la conception des NTIC.

2- Approche qui incorpore des recommandations et des règles éthiques, de manière évolutive dans le temps, tout le long du cycle de vie des NTIC, c’est-à-dire jusqu’à sa mise en place, son utilisation évolutive.

3- La méthode AXIOETK se base sur la connaissance approfondie des statistiques traditionnelles ainsi que celles issues de la Data Science (Machine Learning, Deep Learning).

4- https://adeliaa.fr/ia-ethique-et-responsable/

Tribune de Magali Germond, Directrice du pôle Data Strategy chez ADELIAA et Déléguée Régionale des Femmes du Numérique en Occitanie, et de Jérôme Béranger, CEO d’ADELIAA, Chercheur (PhD) associé au CERPOP – Inserm – Université de Toulouse et auteur de plusieurs ouvrages dont « La responsabilité sociétale de l’intelligence artificielle » (Mars 2021, Le Passeur)