PandaSet, un ensemble de jeux de données pour la conduite autonome a été mis à disposition sur GitHub par le fabricant de capteurs Hesai & la start-up Scale AI. Il permet aux chercheurs d’étudier des situations de conduite urbaine difficiles en utilisant la combinaison de capteurs complète d’une vraie voiture autonome.

La base de données issues des Lidar vise à promouvoir et à faire progresser la recherche et le développement dans la conduite autonome et le machine learning.

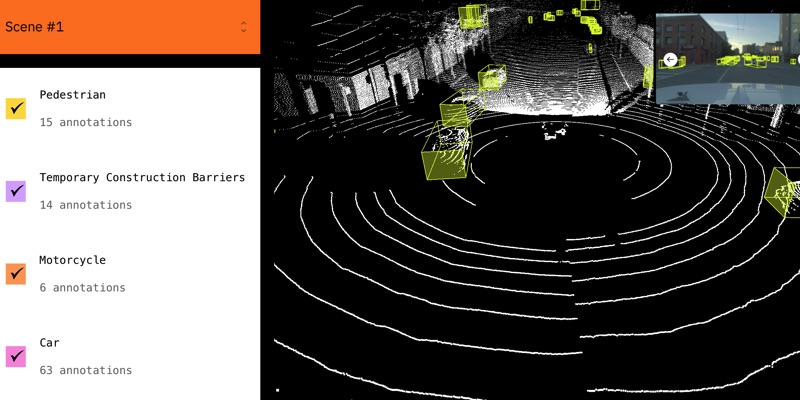

Premier ensemble de données open source mis à disposition pour une utilisation à la fois académique et commerciale, PandaSet combine les meilleurs capteurs LiDAR de Hesai avec l’annotation de données de haute qualité de Scale AI. Il également propose des données collectées à l’aide d’un LiDAR orienté vers l’avant avec une résolution de type image (PandarGT) ainsi qu’un LiDAR à rotation mécanique (Pandar64). Les données collectées ont été annotées avec une combinaison d’annotations cuboïdes et de segmentation (Scale 3D Sensor Fusion Segmentation).

La plate-forme PandaSet comporte :

- 48 000 images de caméra

- 16 000 balayages Lidar

- +100 scènes de 8s chacune

- 28 classes d’annotations

- 37 labels de segmentation sémantique

- Suite complète de capteurs: 1x LiDAR mécanique, 1x LiDAR à semi-conducteurs, 6x caméras, GPS / IMU embarqué

Scénarios de conduite complexes en milieu urbain

Pour créer PandaSet, Scale AI et Hesai ont planifié des itinéraires et sélectionné des scènes qui présenteraient des scénarios de conduite urbaine complexes, notamment des collines escarpées, des zones de construction, une circulation dense et des piétons, ainsi qu’une variété d’heures de la journée et des conditions d’éclairage le matin, l’après-midi, le crépuscule et le soir. Les données ont été récupérées sur un mini-van Chrystler Pacifica sur lequel ont été installés plusieurs caméras et lidar Hesai sur deux itinéraires réalisés dans la Silicon Valley.