Huit géants de la technologie, AMD, Broadcom, Cisco, Google, Hewlett Packard Enterprise (HPE), Intel, Meta et Microsoft, ont annoncé le 30 mai dernier la formation du consortium Ultra Accelerator Link (UALink). Leur collaboration vise à élaborer une norme sectorielle ouverte pour la communication à haute vitesse et à faible latence entre les accélérateurs d'IA dans les centres de données, permettant ainsi de surmonter les limitations actuelles en matière de transfert de données et de calcul parallèle.

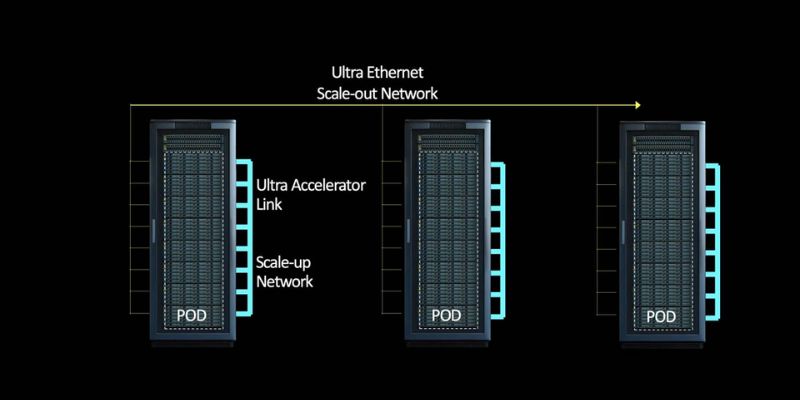

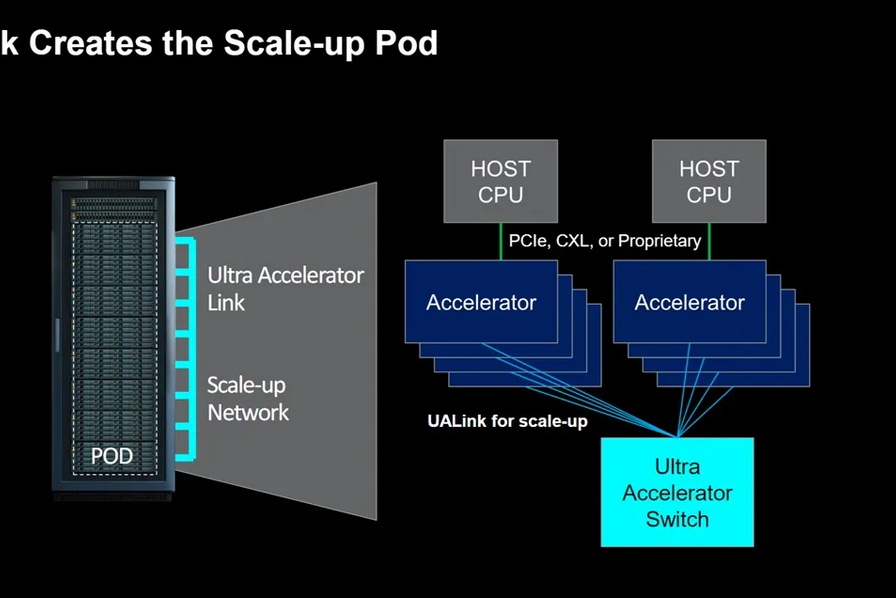

Face à la demande croissante de calculs IA, la nécessité de réseaux robustes, efficients et évolutifs est primordiale. UALink s'engage à établir une interface standard ouverte qui facilitera la communication entre les accélérateurs d'IA, tels que les GPU, et les commutateurs dans les pods de calcul d'IA. En développant cette norme, le groupe fondateur permet aux équipementiers, intégrateurs de systèmes de centres de données et professionnels de l'informatique de créer des solutions plus intégrées, flexibles et évolutives.

Forrest Norrod, vice-président exécutif et directeur général, Data Center Solutions Group, AMD, commente :

"Le travail effectué par les entreprises d’UALink pour créer un tissu d’accélérateur ouvert, hautement performant et évolutif est essentiel pour l’avenir de l’IA. Ensemble, nous apportons une vaste expérience dans la création de solutions d'IA à grande échelle et de calcul haute performance basées sur des normes ouvertes, l'efficience et un soutien robuste à l'écosystème".

En adoptant UALink, les entreprises évitent le verrouillage technologique souvent associé à des solutions comme NVLink. La norme UALink 1.0 est conçue pour permettre la connexion de jusqu'à 1024 accélérateurs au sein d'un pod de calcul d'IA, et permettra des charges directes et des stockages entre la mémoire attachée aux accélérateurs dans le pod, offrant une échelle de connexion plus grande et plus flexible que les solutions actuelles.NVLink 5.0, la dernière génération de la technologie de NVIDIA, présentée à la GTC 2024, permet quant à elle des transferts de données rapides entre les GPU et entre les GPU et les CPU. Elle permet, grâce au commutateur NVSwitch, de connecter jusqu’à 576 GPU Blackwell B200.

Support de divers accélérateurs

Contrairement à NVLink, qui est optimisé principalement pour les GPU NVIDIA, UALink vise à supporter une variété d'accélérateurs, y compris les GPU, les TPU (Tensor Processing Units), les FPGA (Field-Programmable Gate Arrays) et d'autres processeurs spécialisés. Cette flexibilité permet d'optimiser les performances pour une gamme plus large de charges de travail, qu'il s'agisse de l'apprentissage profond, de la simulation scientifique ou d'autres applications HPC.

Le consortium UALink prévoit sa constitution officielle et la publication de sa première spécification (1.0) au troisième trimestre de 2024. Cette spécification sera mise à la disposition des entreprises qui rejoignent le consortium, ouvrant la voie à une nouvelle ère d'innovation et de performance dans le domaine de l'IA.