Dans le cadre d'une étude, plusieurs chercheurs d'IBM, du Massachussetts Institute of Technology (MIT) et de l'Université de Stanford se sont associés pour lancer le "ThreeDWorld Transport Challenge". Son objectif est d'évaluer la capacité des systèmes d'intelligence artificielle à trouver des chemins, à interagir avec des objets ou encore à planifier des taches efficacement. À l'heure actuelle, aucun modèle d'IA n'a réussi à relever le défi.

Un défi lancé par une équipe de chercheurs

Dans le domaine de la robotique, réussir à développer un système permettant de détecter physiquement le monde et pouvant interagir avec son environnement est souvent présenté comme l'un des principaux défis de l'intelligence artificielle. Aujourd'hui, même si les réalisations peuvent être remarquables, elles sont encore très loin des capacités humaines.Une équipe de chercheurs du MIT, d'IBM et de Stanford ont lancé un défi intitulé ThreeDWorld Transport Challenge. Parmi les scientifiques collaborant à ce projet, on retrouve Chunang Gan, Abhishek Bhandwaldar, Jeremy Schwartz, Seth Alter, Todd, Mummert, Josh McDermott, Daniel Yamins, James DiCarlo, Siyuan Zhou, Antonio Torrala, Joshua Tenenbaum et Dan Gutfreund.

L'objectif du défi est simple : si le système d'intelligence artificielle réussit l'ensemble des épreuves, il sera considéré comme très évolué. À noter qu'aucun système à l'heure actuelle n'a réussi à compléter ce défi. Mais alors, pourquoi proposer à des systèmes d'IA, un défi qui semble irréalisable ? En réalité, les chercheurs s'interrogent sur les limites des modèles actuels. Les résultats du concours pourront déterminer les axes de recherches à privilégier.

Un environnement virtuel créé spécialement pour ce défi

La plupart des applications de robotique utilisent l'apprentissage par renforcement. La création de ce genre de modèles présente plusieurs enjeux :- L'un d'eux consiste à en concevoir un qui prend en compte plusieurs facteurs comme la gravité, le vent, les interactions physiques avec les objets ou d'autres personnes. Tout l'inverse d'environnements comme les échecs où les machines gagnent désormais contre l'homme.

- La collection de données est un autre enjeu de taille : les systèmes d'apprentissage par renforcement doivent s'entrainer grâce à des données très fournies, quitte à simuler des millions d'interactions avec leur environnement. Ce genre de procédés peut ralentir les systèmes robotiques, car elles doivent collecter leurs données dans le monde physique qui varie constamment.

Un test complexe pour des modèles d'apprentissage par renforcement

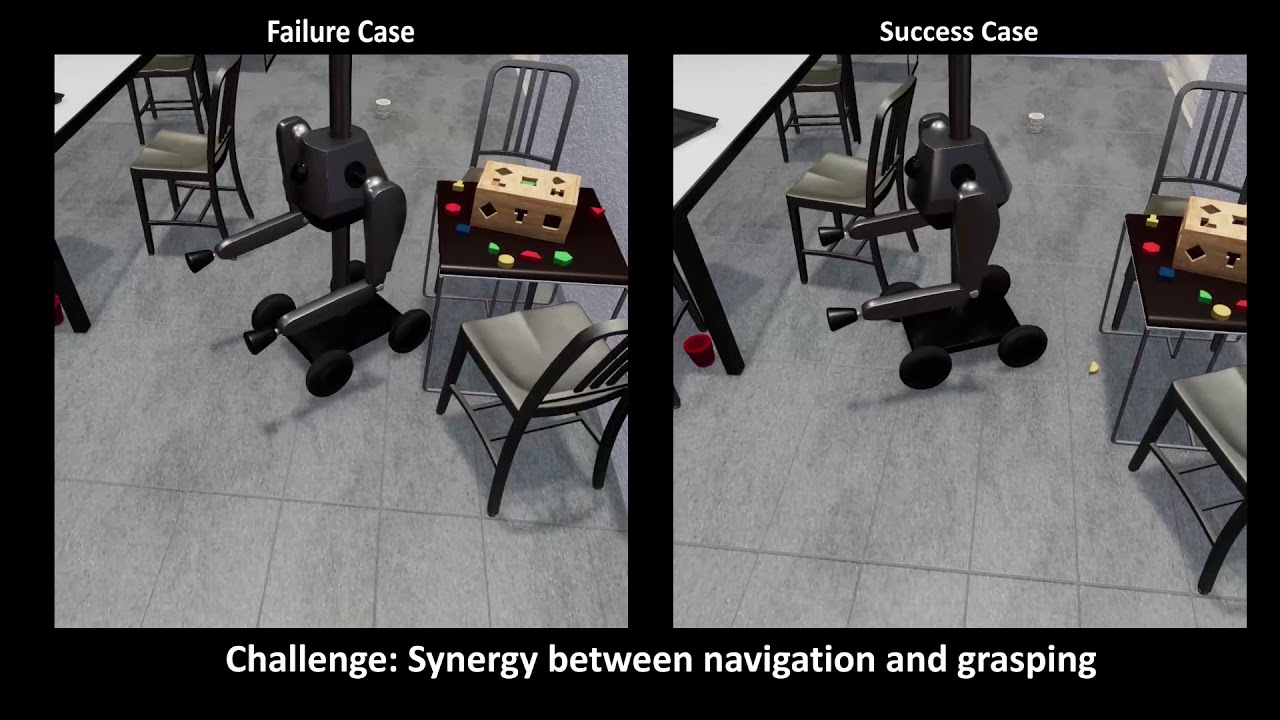

Les tests d'apprentissage par renforcement ont différents degrés de difficulté. En général, les plus courants impliquent que le robot puisse trouver son chemin dans un environnement virtuel. Le ThreeDWorld Transport Challenge propose quelque chose de plus complexe en proposant des problèmes de "planification des tâches et des mouvements" (TAMP), ce qui demande au robot de trouver des trajectoires optimales, mais également de manipuler des objets qui seraient sur son chemin.L'environnement virtuel se compose d'une maison avec plusieurs pièces avec des meubles et objets. Le robot adopte un point de vue à la première personne et doit trouver plusieurs objets afin de les rassembler à un endroit spécifique. Le robot est doté de deux bras et ne peut donc transporter que deux objets à la fois. Des conteneurs sont présents dans les pièces, la machine peut les utiliser pour transporter plusieurs objets et ainsi, réduire le nombre de déplacements à effectuer.

Le robot doit réaliser ces tâches en un minimum d'étapes, sachant qu'une action (tourner, avancer, ramasser un objet, lâcher un objet) correspond à une étape. Un des robots virtuels testés dans le cadre de ce défi se nomme Magnebot. Il possède deux bras avec neuf degrés d'inclinaison, des articulations aux poignets, aux coudes et aux épaules. Toutefois, ses mains sont des aimants, car la manipulation avec les doigts est une tâche extrêmement difficile à réaliser.

Des résultats encourageants, mais loin d'être satisfaisant

Pour éviter toute confusion, les tâches du défi sont proposées au robot dans un langage codé simple, comprenant le nom de l'objet et un nombre correspondant à la tache qu'il doit réaliser avec l'objet. Pour réduire le champ d'action, les chercheurs ont limité la navigation du robot à des mouvements de 25 centimètres et à des rotations de 15 degrés. Cela a permis aux développeurs de se concentrer sur les problèmes de navigation et de planification des taches que le robot doit surmonter.Selon les expériences déjà réalisées par les chercheurs, seuls 10 % des tests TDW sont un succès pour les modèles les plus performants d'apprentissage par renforcement. Ils ont également essayé de développer des modèles hybrides où le système de base était combiné à un planificateur de haut niveau et ont constaté une amélioration considérable des performances du système. Cependant, le problème reste en partie non résolu puisque les meilleurs robots testés ont un taux de réussite d'environ 50 %.