Depuis l’émergence des grands modèles de langage (LLMs), certains ont été qualifiés d’“ouverts”, ce qui a pu prêter à confusion avec le terme “open source” lors de leur présentation. En février dernier, l’Allen Institute for Artificial Intelligence (Ai2), a publié la première version d’OLMo, (Open Language Model), un LLM qui répond aux critères stricts de l’OSAID, la définition de l’IA open source de l’OSI. Le modèle a depuis été mis à jour en avril et dernièrement avec OLMo 2 qu’il présente comme “le meilleur modèle de langage entièrement ouvert à ce jour”.

AI2 est un institut de recherche à but non-lucratif fondé en 2014 par Paul Allen, philanthrope et cofondateur de Microsoft, décédé en 2018. Son objectif est de favoriser le développement de l’intelligence artificielle au service de la société, en mettant l’accent sur des applications responsables et éthiques. L’institut collabore avec des universités, des entreprises et d’autres institutions de recherche pour stimuler l’innovation dans ce domaine.

AI2 se concentre sur des domaines variés tels que la compréhension du langage naturel, la vision par ordinateur, l’apprentissage automatique et la robotique. Parmi ses contributions majeures, on trouve Semantic Scholar, un moteur de recherche avancé destiné à aider les chercheurs à accéder et à analyser des articles scientifiques, ainsi que AllenNLP, une bibliothèque open source dédiée au traitement du langage naturel.

OLMo 2

Dans le domaine de la GenAI, AI2 milite également pour l’open source. Après Molmo, une famille de modèles d’IA multimodaux, il présente OLMo2, sa dernière famille de modèles de langage.

Dans le cadre de la validation et de la mise à l’essai de l’OSAID, la première version d’OLMo a été considérée comme réellement open source tout comme Pythia (Eleuther AI), Amber et CrystalCoder (LLM360) et T5 (Google) contrairement à Llama de Meta ou Grok de xAI. OLMo 2 correspond lui aussi pleinement aux critères exigés.

AI2 écrit sur son blog :

“Parce que la science entièrement ouverte nécessite plus que des poids ouverts, nous sommes ravis de partager une nouvelle série de mises à jour d’OLMo, y compris des poids, des données, du code, des recettes, des points de contrôle intermédiaires et des modèles optimisés pour les instructions, avec la communauté plus large de la modélisation du langage !”

Une architecture améliorée et un pré-entraînement optimisé

OLMo 2 est une nouvelle famille de modèles de langage de 7 et 13 milliards de paramètres, le premier a été entraîné sur environ 4,05 milliards de tokens tandis que le second l’a été sur un total de 5 000 milliards de tokens.

Les modifications architecturales principales apportées à OLMo incluent l’intégration de RMSNorm pour une meilleure stabilité et l’utilisation de plongements positionnels rotatifs.

AI2 a utilisé une approche en 2 étapes. Pour la 1ère, les modèles ont été pré-entraînés avec OLMo-Mix-1124, une collection d’environ 3,9 milliards de jetons. Les modèles ont, dans un second temps, été affinés avec un mélange composé à part égale de données web filtrées et de données spécifiques à un domaine (contenu académique, forums de questions-réponses, données d’instructions et cahiers d’exercices mathématiques, à la fois synthétiques et générés par l’homme) provenant de Dolmino-Mix-1124. L’Institut a ensuite échantillonné les 843 milliards de tokens obtenus pour optimiser leurs performances lors des étapes finales d’entraînement.

Performance et comparaison de OLMo 2

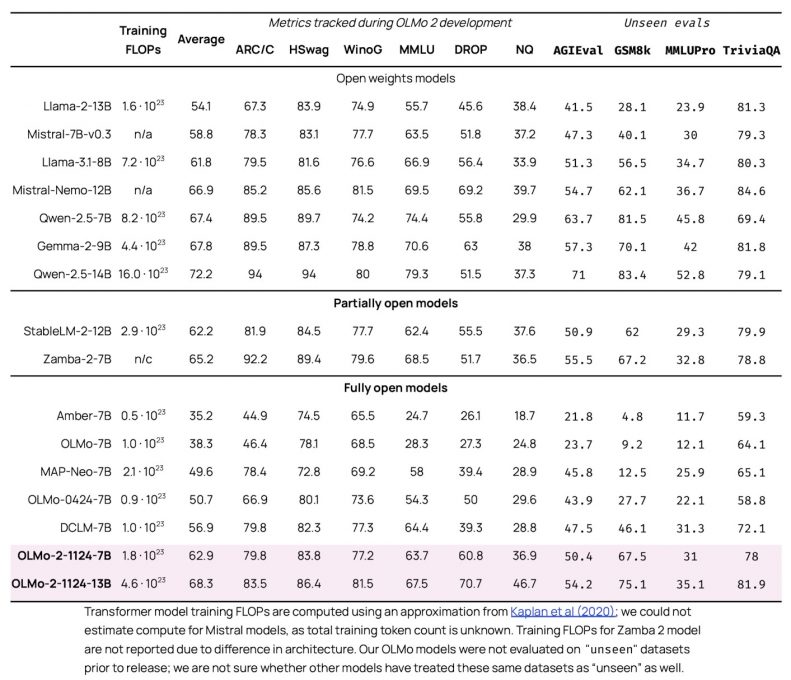

Selon les évaluations d’AI2, OLMo 2 7B et 13B sont les meilleurs modèles entièrement ouverts à ce jour, surpassant souvent les modèles de “poids ouverts” de taille équivalente, tout en égalant voire dépassant certains modèles partiellement propriétaires. Par exemple, OLMo-2-7B surpasse Llama 3.1 8B de Meta tandis qu’OLMo-2-13B dépasse Qwen 2.5 7B d’Alibaba Cloud malgré un coût de calcul moindre.

AI2 a utilisé Tülu 3, sa famille de modèles de suivi d’instructions, pour les variantes Instruct d’OLMo 2. Celles-ci ont été évaluées sur leurs capacités de suivi d’instructions, de rappel des connaissances, de mathématiques et de raisonnement général. Elles se sont révélées compétitives avec les meilleurs modèles à poids ouverts, OLMo 2 13B Instruct surpassant les modèles Qwen 2.5 14B instruct, Tülu 3 8B et Llama 3.1 8B instruct.