Les modèles de langage de petite taille (SLM) sont une alternative intéressante aux LLMs pour les entreprises qui peuvent les exploiter à moindre coût pour des tâches spécifiques. Microsoft après avoir introduit le SLM Phi-1 en juin 2023 et présenté le 23 avril dernier la famille de modèles open source Phi-3, dévoile à présent les modèles Phi-3,5 : Phi-3.5-mini-instruct, Phi-3.5-MoE-instruct, et Phi-3.5-vision-instruct.

Chacun de ces modèles est optimisé pour des tâches spécifiques, tout en partageant une longueur de contexte de 128 000 jetons, permettant une manipulation efficace des données complexes.

Phi-3.5-mini-instruct : un modèle compact et puissant pour environnements restreints

Le Phi-3.5-mini-instruct est le plus petit modèle de la série, conçu pour offrir des performances robustes dans des environnements où les ressources informatiques sont limitées. Avec 3,8 milliards de paramètres, ce modèle est parfaitement adapté aux tâches nécessitant un raisonnement logique solide, telles que la génération de code et la résolution de problèmes mathématiques.

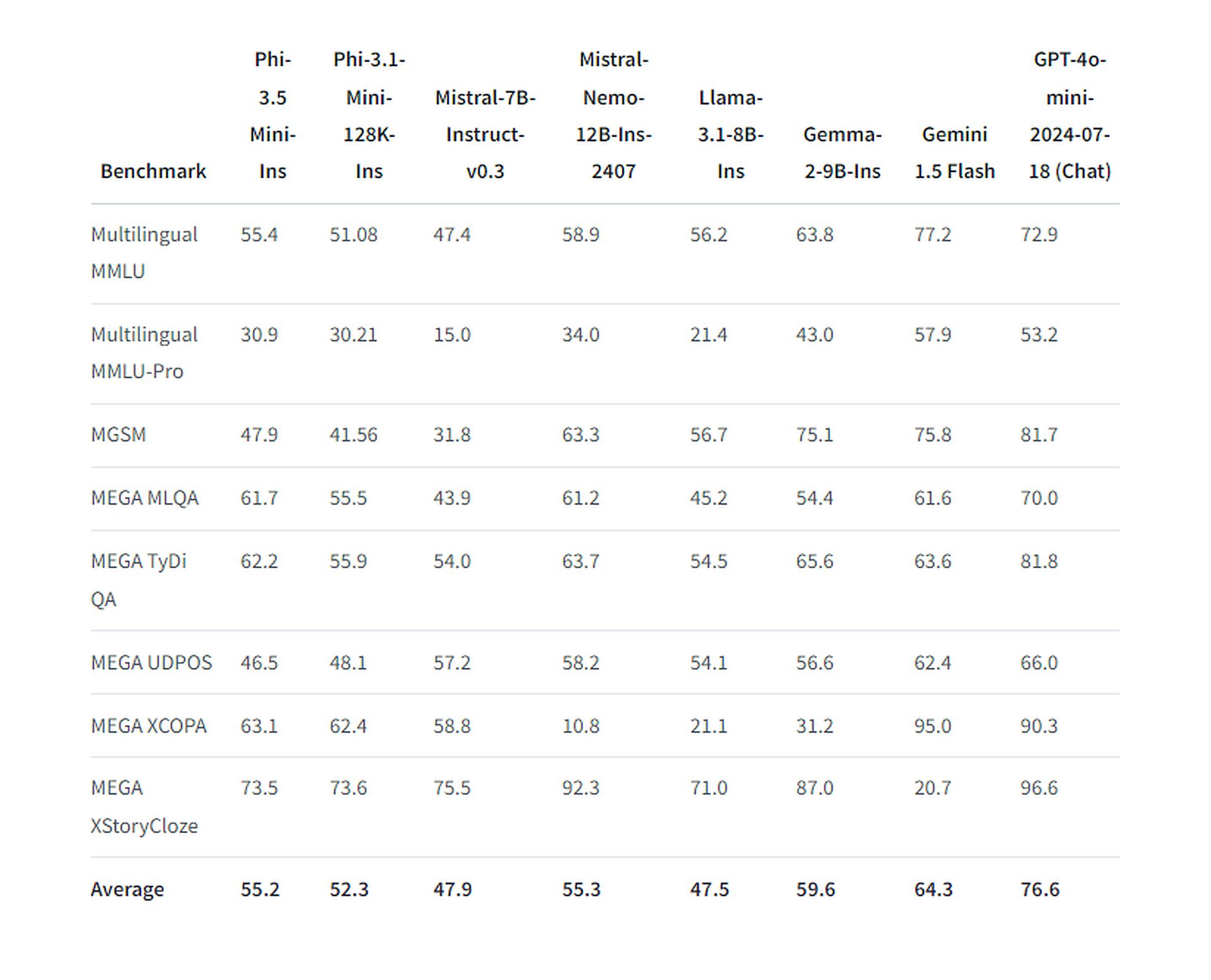

Malgré sa taille réduite, ce modèle a été entraîné sur un impressionnant ensemble de 3,4 billions de jetons à l’aide de 512 GPU H100-80G pendant 10 jours. Les performances de Phi-3.5 Mini Instruct dans les tâches conversationnelles multilingues et multi-tours sont remarquables. Le modèle est compétitif avec d’autres modèles ouverts beaucoup plus grands tels que Llama-3.1-8B-instruct, Mistral-7B-instruct-v0.3 et Mistral-Nemo-12B-instruct-2407. Il a notamment surpassé Llama-3.1-8B-instruct et Mistral-7B-instruct-v0.3 dans le benchmark RepoQA (compréhension du code à contexte long).

Phi-3.5-MoE-instruct : une architecture de mélange d’experts

Le modèle Phi-3.5-MoE (Mixture of Experts) représente une avancée significative dans l’architecture de l’IA. Ce modèle utilise une approche sophistiquée qui active différents “experts” en fonction de la tâche à accomplir, optimisant ainsi les performances pour des tâches spécifiques. Avec 42 milliards de paramètres, dont 6,6 milliards activés à chaque utilisation, le Phi-3.5 MoE est conçu pour gérer des tâches de raisonnement complexes, la compréhension de code et le traitement multilingue.

Il prend en charge les langues suivantes : Allemand, Anglais, Arabe, Chinois, Coréen, Danois, Espagnol, Finnois, Français, Hébreu, Hongrois, Italien, Japonais, Norvégien, Néerlandais, Polonais, Portugais, Russe, Suédois, Thaï, Turc et Ukrainien.

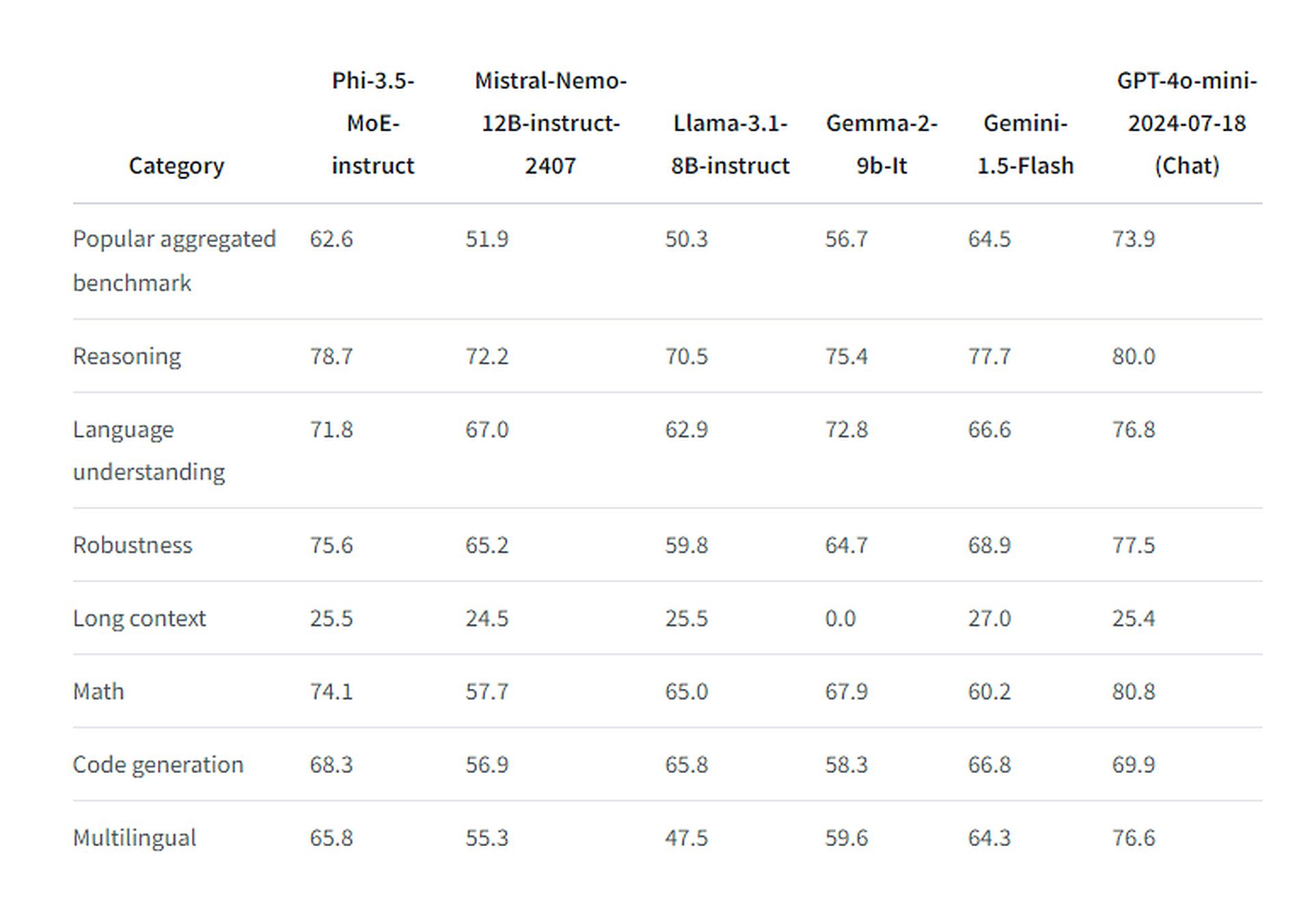

Entraîné sur 4,9 billions de jetons, dont 10 % multilingues, en utilisant 512 GPU H100-80G pendant 23 jours, le modèle MoE a montré une supériorité notable dans les tests de performance spécifiques. Il a surpassé les modèles plus grands Llama 3.1-8B-instruct, Gemma 2-9B-It et Gemini 1.5-Flash mais s’est incliné face à GPT-4o-mini d’OpenAI, dans la majorité des cas. Cependant, dans le test MMLU (Massive Multitask Language Understanding) à 5 coups, il a réussi à prendre l’avantage sur ce dernier.

Microsoft commente :

“Il est encore fondamentalement limité par sa taille pour certaines tâches. Le modèle n’a tout simplement pas la capacité de stocker trop de connaissances factuelles, par conséquent, les utilisateurs peuvent rencontrer des inexactitudes factuelles. Cependant, nous pensons qu’une telle faiblesse peut être résolue en augmentant Phi-3.5 avec un moteur de recherche, en particulier lors de l’utilisation du modèle sous les paramètres RAG”.

Le modèle a fait l’objet d’un processus d’amélioration rigoureux, intégrant un réglage fin supervisé, une optimisation des politiques proximales et une optimisation des préférences directes pour garantir une adhésion précise aux instructions et des mesures de sécurité robustes.

Phi-3.5-vision-instruct : pour les tâches multimodales

Le Phi-3.5-vision-instruct est conçu pour les tâches multimodales, intégrant à la fois des données textuelles et visuelles. Avec 4,15 milliards de paramètres, ce modèle est spécialement adapté pour des applications telles que la reconnaissance optique de caractères (OCR), la compréhension de graphiques et de tableaux, et le résumé vidéo.

Il a été entraîné sur 500 milliards de jetons avec 256 GPU A100-80G sur une période de 6 jours. Son aptitude à traiter et à intégrer des données complexes, combinée à sa capacité à gérer plusieurs images, en fait un outil extrêmement polyvalent pour les tâches nécessitant une analyse détaillée des informations visuelles et textuelles.

Open source pour une adoption généralisée

Les trois modèles de la série Phi-3.5 sont disponibles sous licence MIT, ce qui permet aux développeurs de les utiliser, de les modifier et de les distribuer sans restriction. Ils sont disponibles sur Hugging Face, Phi-3.5 Vision Instruct est également accessible via Azure AI Studio.