Le premier des “12 jours d’OpenAI” a été marqué par l’annonce de ChatGPT Pro et du modèle OpenAI o1, jusqu’alors en preview. Le 20 décembre dernier, la start-up a clos la série en beauté en dévoilant la famille o3, encore en phase de test, doté de capacités de raisonnement nettement améliorées.

OpenAi o3 est la version améliorée de son prédécesseur o1.O2 étant le nom du plus grand opérateur de réseau mobile au Royaume-Uni, OpenAI a préféré faire l’impasse sur o2 pour éviter tout conflit.

Les capacités de raisonnement avancées d’OpenAI o1 et o3 reposent sur la chaîne de pensée (chain of thought) et l’apprentissage par renforcement (reinforcement learning ou RL). La chaîne de pensée est un processus où l’IA décompose un problème complexe en sous-problèmes plus simples avant de proposer une solution. Grâce à l’apprentissage par renforcement, les modèles perfectionnent cette chaîne de pensée et affinent leurs stratégies. Ils apprennent à identifier et à corriger leurs erreurs, à décomposer les étapes complexes en étapes plus simples, et à essayer une approche différente lorsque l’approche utilisée ne fonctionne pas.

La capacité à décomposer un problème en étapes et à tenter d’élaborer un jugement critique sur les réponses fournies afin de simuler une réflexion humaine est particulièrement utile dans les domaines nécessitant un raisonnement long et nuancé :

- Mathématiques complexes : Résolution de problèmes en plusieurs étapes, où une simple erreur de calcul ou de logique dans une étape peut compromettre le résultat final ;

- Programmation : Analyse des erreurs dans un code et élaboration d’une solution optimale après avoir envisagé plusieurs options ;

- Sciences : Compréhension et application de théories scientifiques complexent pour résoudre des questions à plusieurs facettes.

La famille OpenAI o3

La nouvelle famille compte deux modèles : o3 et o3-mini, une version plus rapide et plus économique, offrant des capacités similaires à une fraction du coût et de la latence du modèle o1-mini qui excelle, selon OpenAI dans les STEM, en particulier les mathématiques et le codage.

Les performances d’o3

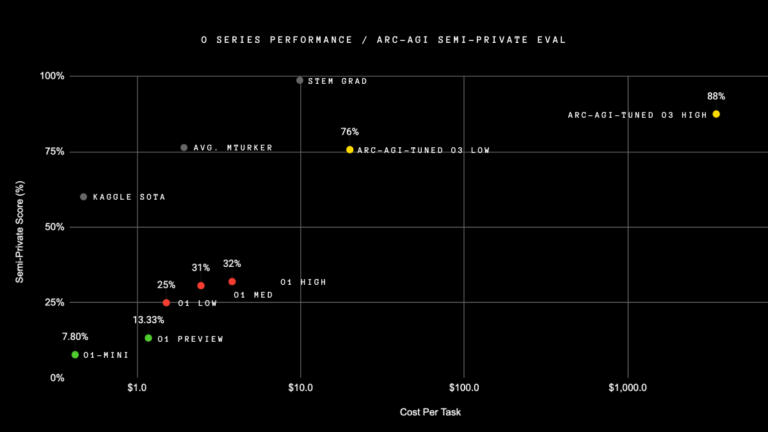

Sur le benchmark « Abstract and Reasoning Corpus for Artificial General Intelligence » (ARC-AGI) développé par le créateur de Keras, la bibliothèque d’apprentissage profond open source, François Chollet, afin de mesurer l’efficacité de l’acquisition de compétences par l’IA sur des tâches inconnues, o3 a atteint les meilleurs scores : il a non seulement triplé les performances de o1 avec un score de 75.7% sur une évaluation semi-privée où les ressources de calcul sont limitées, mais atteint celui de 87,5 % sur le paramètre de calcul élevé.

François Chollet souligne toutefois qu’o3 pourrait voir son score potentiellement réduit à moins de 30 % lors du prochain benchmark ARC-AGI-2, prévu pour 2025, même à un calcul élevé (alors qu’un humain intelligent serait toujours capable de marquer plus de 95 % sans formation).

Sur d’autres benchmarks, comme GPQA Diamond en mathématiques, EpochAI’s Frontier Math Benchmark ou Codeforces, il a également démontré des performances impressionnantes.

Des modèles plus sûrs

OpenAI dit avoir développé pour ses modèles “o” une nouvelle technique de sécurité appelée “alignement délibératif” qui utilise les capacités de raisonnement des modèles pour mieux identifier les prompts, sûrs et non-sûrs, améliorant ainsi leur performance en matière de sécurité.

Vers l’IAG ?

Si le modèle rapproche un peu plus OpenAI de l’IAG, il peine encore à résoudre des tâches simples. Il est en outre coûteux, nécessitant des ressources de calcul substantielles pour atteindre ses performances optimales : environ 20 $ par tâche pour une faible puissance de calcul, plusieurs milliers par tâche pour des configurations à calcul élevé, ce qui peut entraver son déploiement à grande échelle.

OpenAI a ouvert un accès anticipé aux modèles o3 et o3-mini pour les chercheurs en sécurité afin de tester les modèles avant leur lancement public, prévu pour fin janvier pour o3-mini et peu après pour o3.