NVIDIA annonce le lancement d'un nouveau service NVIDIA AI Foundry qui permettra aux entreprises d'utiliser la nouvelle famille Llama 3.1 pour créer des modèles personnalisés avec leurs données propriétaires ainsi que des données synthétiques générées par Llama 3.1 405B et le modèle NVIDIA Nemotron.

Le service couvre la curation, la génération de données synthétiques, le réglage fin, la récupération, les garde-fous et l’évaluation pour déployer des microservices NVIDIA NIM Llama 3.1 personnalisés avec les nouveaux microservices NVIDIA NeMo Retriever introduits le 23 juillet dernier pour des réponses précises.

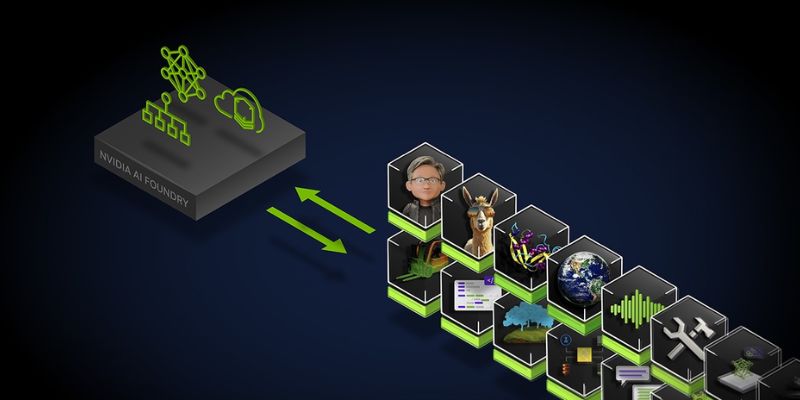

NVIDIA avait lancé NVIDIA AI Foundry, une plateforme permettant de créer des modèles d’IA génératifs personnalisés avec des données d’entreprise et des connaissances spécifiques à un domaine, en novembre dernier sur Microsoft Azure. Ce service rassemblait trois éléments : une collection de modèles de base d’IA NVIDIA, le cadre et les outils NeMo de NVIDIA ainsi que les services de calcul intensif d’IA dans le cloud NVIDIA DGX, afin d'offrir aux entreprises une solution de bout en bout pour créer des modèles d’IA génératifs personnalisés.

Aujourd'hui, les entreprises peuvent utiliser le nouveau service AI Foundry pour personnaliser les modèles communautaires y compris la nouvelle collection Llama 3.1, ainsi que NVIDIA Nemotron, CodeGemma de Google DeepMind, CodeLlama, Gemma de Google DeepMind, Mistral, Mixtral, Mistral NeMo 12b, présenté il y a quelques jours, Phi-3, StarCoder2 et d’autres.

Les clients peuvent générer leurs modèles AI Foundry sous forme de microservices d’inférence NVIDIA NIM (NeMo Inference Microservices), qui incluent le modèle personnalisé, des moteurs optimisés et une API standard, pour s’exécuter sur l’infrastructure accélérée de leur choix. Ces microservices permettent une exécution rapide et efficace des modèles d'IA en production, avec des améliorations significatives des performances par rapport aux méthodes d’inférence traditionnelles.

Comment fonctionne NVIDIA AI Foundry ?

NVIDIA AI Foundry utilise des données d’entreprise, ainsi que des données générées synthétiquement, pour augmenter et modifier les connaissances générales contenues dans un modèle de fondation pré-entraîné. Une fois que le modèle est personnalisé, évalué et doté de garde-fous, il est généré en tant que microservice d’inférence NIM de la plateforme NVIDIA AI Enterprise 5.0 introduite en mars dernier lors de la GTC 2024. Les développeurs utilisent l’API standard du NIM pour créer des applications génératives alimentées par l’IA. Les connaissances acquises à partir des applications en cours de déploiement peuvent être réinjectées dans AI Foundry afin d’améliorer encore les modèles personnalisés.Accenture, Aramco, AT&T, Uber sont parmi les premiers à utiliser les nouveaux microservices Llama NVIDIA NIM.