Les modèles de langage pré-entraînés font l'objet d'une attention croissante pour traiter l'abondance des données dans le domaine biomédical. Alors que la majorité des recherches actuelles utilisent des modèles BERT, Microsoft Research a décidé de s'appuyer sur GPT-2 et présente BioGPT, un modèle de langage Transformer génératif préformé pour la génération et l'exploration de texte biomédical.

Grâce au traitement naturel du langage (NLP), le text mining ou extraction de connaissances dans la littérature biomédicale, joue un rôle très important dans le développement de nouveaux médicaments, la thérapie clinique, la recherche en pathologie...

Parmi les deux principales branches de modèles de langage pré-formés dans le domaine du langage général, c'est-à-dire BERT, GPT et leurs variantes, la première a été largement étudiée dans le domaine biomédical, notamment avec BioBERT et PubMedBERT. Bien que ceux-ci aient obtenu un grand succès sur une variété de tâches biomédicales discriminantes en aval, leur manque de capacité de génération limite leur champ d'application.

L'équipe de Microsoft Research a choisi de s'appuyer sur GPT, qui n'avait pas encore réellement été étudié pour le domaine biomédical. Dans cette étude, elle propose le modèle de langage BioGPT, basé sur GPT-2, pré-entraîné pour la génération de textes biomédicaux et le text mining à grande échelle, soit sur 15 millions de titres et résumés PubMed.

Les chercheurs soulignent que le vocabulaire dans le domaine est crucial. Plutôt que d’utiliser le vocabulaire de GPT-2, ils ont opté pour celui du corpus collecté et ont utilisé le codage de paire d’octets pour segmenter les mots dans le corpus en morceaux de mots et apprendre le vocabulaire.

Le modèle a ensuite été affiné pour s'adapter aux tâches en aval. Les chercheurs ont alors conçu et analysé le format de séquence cible et l’invite pour une meilleure modélisation des tâches.

Ils ont ensuite appliqué BioGPT à six tâches biomédicales NLP dont l'extraction de relation de bout en bout, la réponse aux questions et la classification des documents et ont démontré que leur modèle surpasse les modèles précédents sur la plupart des tâches, notamment sur trois tâches d’extraction de relations de bout en bout et une tâche de réponse aux questions.

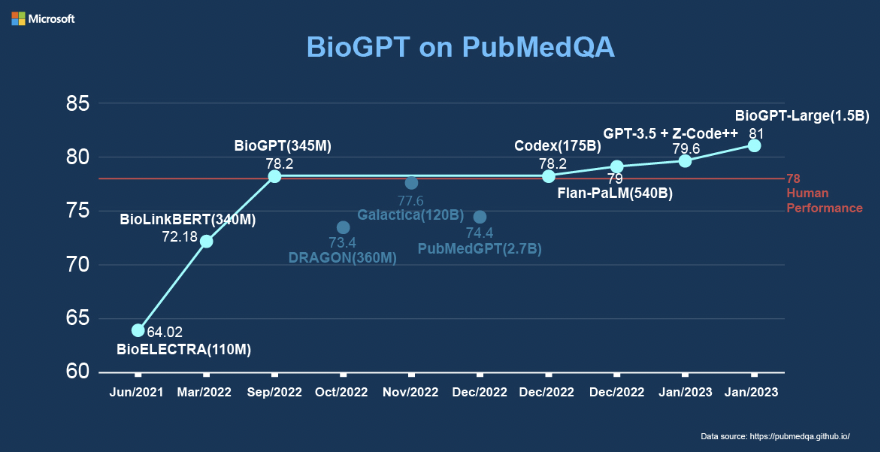

BioGPT a en effet obtenu un score F44 de 98,38%, 42,40% et 76,1% sur les tâches d’extraction de relations de bout en bout BC5CDR, KD-DTI et DDI, respectivement, et une précision de 78,2% sur PubMedQA, un ensemble de données biomédicales sur la réponse aux questions recueillis à partir de résumés PubMed. Leur modèle le plus grand, BioGPT-Large, a quant à lui, atteint les 81%.

Selon les chercheurs, BioGPT génère des descriptions fluides pour les termes biomédicaux, surpassant GPT-2 sur la tâche de génération de texte dans le domaine biomédical.

Microsoft Research envisage d'entraîner BioGPT à une plus grande échelle de données biomédicales et de l'adapter à de nouvelles tâches en aval par le futur.

Références :

"BioGPT: Generative Pre-trained Transformer for Biomedical Text Generation and Mining" arXiv:2210.10341v2, 13 Jan 2023

Auteurs : Renqian Luo, Liai Sun, Yingce Xia, Tao Qin, Sheng Zhang, Hoifung Poon, Tie-Yan Liu