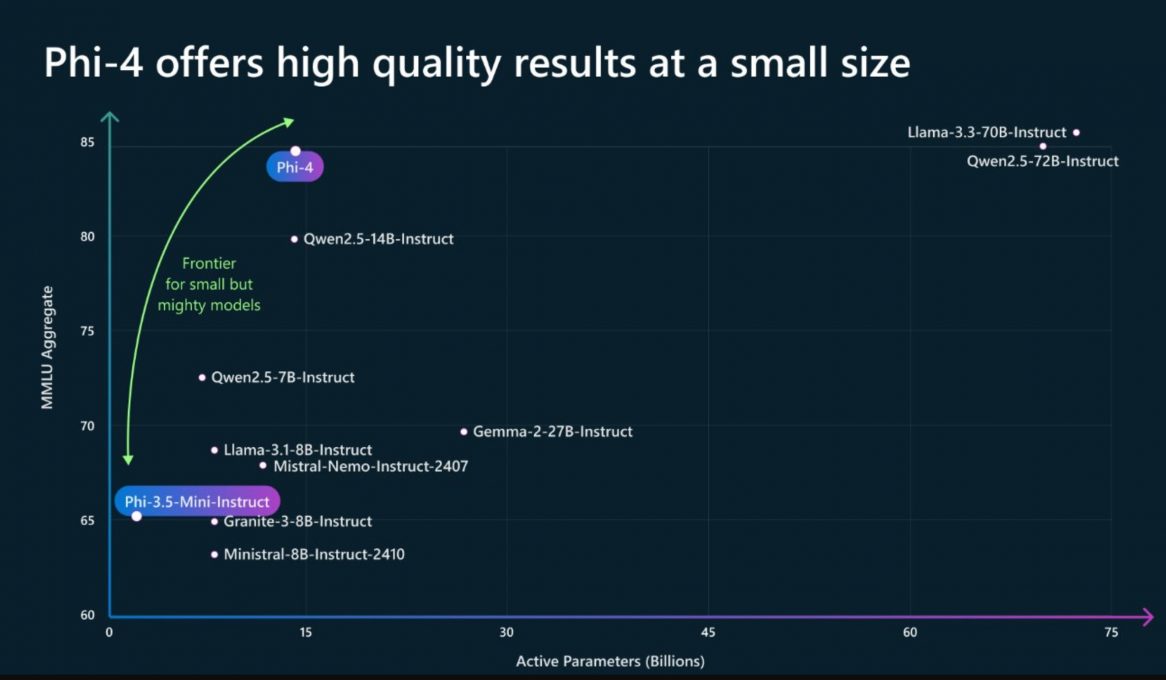

Avec Phi-4, Microsoft démontre une nouvelle fois qu’il est possible de concilier performance et compacité. Ce SLM de 14 milliards de paramètres qui selon l'entreprise "excelle dans le raisonnement complexe dans des domaines tels que les mathématiques, en plus du traitement du langage conventionnel", a réussi à surpasser sur certains benchmarks des modèles de pointe tels que Gemini Pro 1.5, GPT-4o ou Claude 3.5 Sonnet. Alors qu'on a pu voir arriver des LLMs affichant un nombre de paramètres de plus en plus impressionnant, certains acteurs de l'IA comme Mistral AI ou Google proposent désormais des modèles beaucoup plus compacts. Microsoft, avec ses modèles Phi, s'est intéressé au potentiel des SLMs dès avril 2023. Alors qu'il a dévoilé les modèles Phi-3,5 : Phi-3.5-mini-instruct, Phi-3.5-MoE-instruct, et Phi-3.5-vision-instruct, optimisé chacun pour des tâches spécifiques, en août dernier, il introduit Phi-4.

Selon Microsoft, si Phi-4 surpasse des modèles comparables et plus grands sur le raisonnement lié aux mathématiques, c'est grâce aux progrès réalisés depuis le développement de Phi-3.5. Il explique cette avancée par :

- L’usage de données synthétiques de haute qualité, qui enrichissent les capacités du modèle ;

- Des processus de post-formation innovants, optimisant ses réponses pour des tâches spécifiques ;

- Une conservation rigoureuse des données organiques pour maintenir la pertinence linguistique.

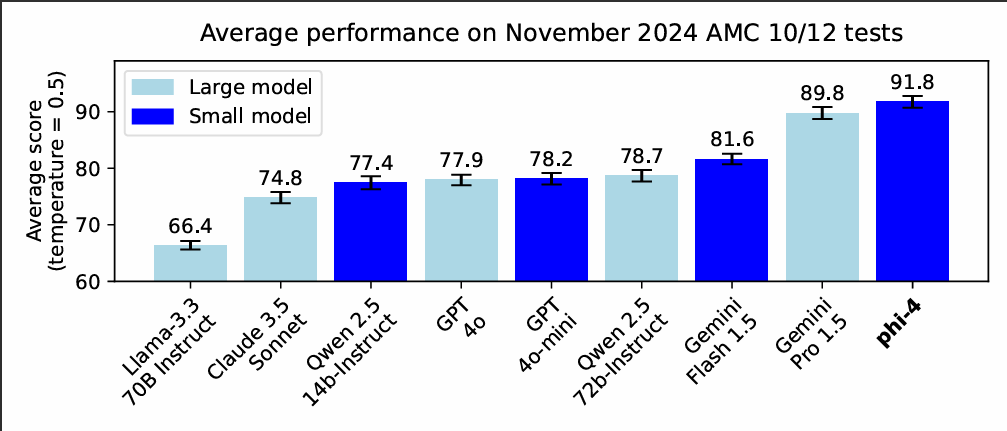

Microsoft a évalué ses performances sur des benchmarks de compétitions mathématiques organisées par la Mathematical Association of America (MAA), notamment les tests AMC 10/12, conçus pour évaluer les compétences en trigonométrie, algèbre, géométrie et probabilité des élèves du secondaire.

Phi-4 a obtenu des résultats impressionnants, surpassant des modèles plus grands comme Gemini Pro 1.5, Claude 3.5 Sonnet et GPT-4o, comme on peut le constater dans ce graphique.

Phi-4 est disponible sous un accord de licence de recherche via Azure AI Foundry. Présentée à Ignite 2024, le mois dernier, cette plateforme fournit des outils robustes pour évaluer, atténuer et gérer les risques liés à l’IA, ce qui garantit une utilisation sûre du modèle. Celui-ci sera également accessible sur Hugging Face dans les prochains jours.