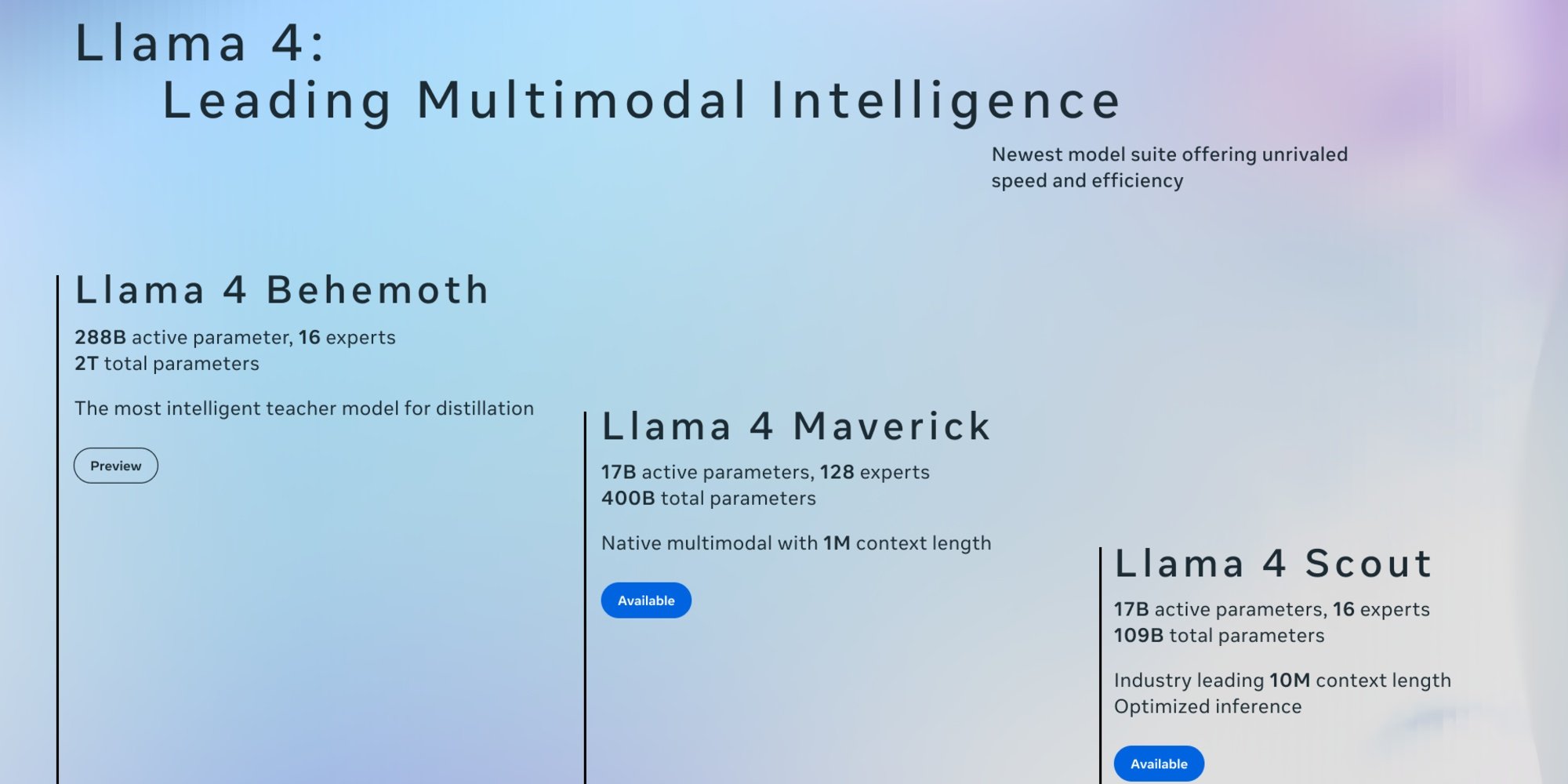

Ce 5 avril, Meta a dévoilé les deux premières versions de Llama 4 : Scout et Maverick. Ces modèles ouverts, conçus pour être nativement multimodaux, peuvent traiter texte, images et vidéos. Grâce à un processus de distillation basé sur Llama 4 Behemoth, le plus grand et le plus puissant modèle de la série encore en développement, ils se distinguent par leur rapidité d’exécution et leur efficacité.

Contrairement aux versions précédentes de Llama qui utilisaient une architecture basée sur les Transformers, Llama 4 repose sur une architecture de Mixture-of-Experts (MoE), où seuls certains paramètres sont activés pour chaque requête. Cette approche améliore l’efficacité et réduit le coût du calcul, Scout et Maverick n'activant "que" 17 milliards de paramètres par requête. Meta a également étendu la prise en charge des langues, qui passe de 8 pour Llama 3.3, présenté en décembre dernier, à 12. Il faut toutefois noter que leur base de connaissances s’arrête en août 2024.

Llama 4 Scout : une fenêtre de contexte inédite

Scout avec 109 milliards de paramètres est le plus léger de la série. Son principal atout est une fenêtre contextuelle pouvant aller jusqu'à 10 millions de tokens, un bond face aux 128 000 jetons de Llama 3. Ajouté au fait qu'il peut fonctionner sur une seule carte Nvidia H100, le modèle est particulièrement adapté aux entreprises ayant des ressources limitées pour des tâches telles que la synthèse multi-document ou l’analyse approfondie des activités utilisateur. Selon les évaluations internes de Meta, Llama 4 Scout offre de meilleures performances que Gemma 3, Mistral 3.1 et Gemini 2.0 Flash Lite.

Llama 4 Maverick

Maverick, compte quant à lui 400 milliards de paramètres et 128 experts, ce qui le rend plus performant. Avec une fenêtre de contexte de 1 million de tokens, Il ouvre la voie à des applications telles que :

-

Des agents d’entreprise intelligents, capables de raisonner et interagir en toute sécurité avec divers outils et flux de travail ;

-

Des systèmes de compréhension de documents, facilitant l’extraction de données structurées à partir de PDF, de numérisations et de formulaires ;

-

Des assistants multilingues, offrant des réponses nuancées et adaptées aux spécificités culturelles ;

-

Des outils de création dédiés à la rédaction d’histoires, de contenus marketing et de textes personnalisés.

Selon Meta, Maverick Llama 4 est le meilleur modèle multimodal de sa catégorie, surpassant GPT-4o et Gemini 2.0 Flash sur un large éventail de benchmarks. Il atteint également des résultats comparables à ceux de DeepSeek v3 en raisonnement et en programmation, tout en utilisant moins de la moitié des paramètres actifs.

De plus, Llama 4 Maverick offre un rapport performance/coût exceptionnel, avec une version expérimentale de chat atteignant un score ELO de 1417 sur LMArena.

Llama 4 Behemoth

Meta a également partagé un aperçu de Llama 4 Behemoth, le modèle enseignant de 2 billions de paramètres (2 000 milliards), qui a servi de base à ces 2 premières versions. Comptant 288 milliards de paramètres actifs avec 16 experts, il offre des performances de pointe alors qu'il n'est pas un modèle spécialisé pour le raisonnement. Il excellerait selon la société en mathématiques, en multilinguisme et sur les benchmarks d’images

Selon ses évaluations, Behemoth surpasserait ainsi GPT-4.5, Claude Sonnet 3.7 et Gemini 2.0 Pro sur différents benchmarks.

Disponibilité

Scout et Maverick sont accessibles sur Llama.com et Hugging Face, distribués en open source sous la licence de Meta qui exige toutefois que les entreprises comptant plus de 700 millions d’utilisateurs actifs mensuels, lui demandent l’autorisation de les utiliser. Si Llama 4 alimente d'ores et déjà Meta AI, l'assistant IA de ses plateformes WhatsApp, Messenger, Instagram dans une quarantaine de pays, les fonctionnalités multimodales ne sont actuellement disponibles qu’aux États-Unis. Côté UE, il va falloir patienter ...