"Deep Learning: Theory, Algorithms and Applications", c'est le nom de la conférence donnée à Berlin en juin dernier par Naftali Tishby, neuroscientist et computer scientist de l'Université de Jérusalem. Une conférence qui a fait des émules car elle présente la méthode "information bottleneck" comme une fondation théorique du deep learning.

Méthode de l'information bottleneck

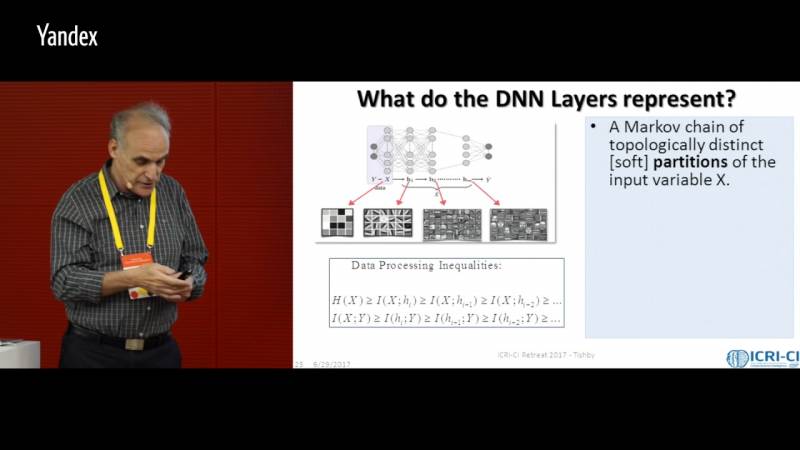

Au cours de sa présentation, le chercheur a mis en avant une théorie permettant de comprendre le fonctionnement du deep learning. Selon lui, les réseaux neuronaux profonds sont capables d'apprendre grâce à ce qu'il appelle l'"information bottleneck". Il s'agit d'une méthode que Naftali Tishby, Fernando C. Pereira et William Bialek avaient décrite, en termes purement théoriques, en 1999.D'après les chercheurs, un réseau traite les multiples données d'entrée renfermant de très nombreux détails en extrayant l'information comme s'il les faisait passer par un goulot de bouteille. Ainsi, il ne retient que les informations les plus importantes en fonction des concepts généraux.

Naftali Tishby et son élève Ravid Shwartz-Ziv ont réalisé de nouvelles expériences informatiques et mis en avant que ce principe d'extraction se produisait au cours de l'apprentissage profond. Cette présentation a donc fortement intéressé les chercheurs puisqu'elle propose une idée originale pour mieux comprendre le deep learning.