Les entreprises œuvrant dans le domaine des modèles de fondation sont de moins en moins transparentes, selon une récente évaluation réalisée par une équipe de chercheurs de l’Université Stanford, du MIT et de Princeton. Cette analyse, menée à l’aide de l’indice “Foundation Model Transparency Index” (FMTI) met en évidence un manque de clarté quant à la construction des modèles de fondation, leur fonctionnement et à la façon dont ils sont utilisés en aval.

Les modèles de fondation, qui alimentent un large éventail d’applications d’IA, deviennent de plus en plus courants. Alors que leur impact sociétal augmente, leur transparence diminue, et ils pourraient devenir tout aussi opaques que les plateformes de médias sociaux. Il est essentiel d’inverser cette tendance : la transparence est une condition préalable essentielle à la responsabilité publique, à l’innovation scientifique et à une gouvernance efficace.

Pour concevoir l’indice de transparence FMTI, Rishi Bommasani, doctorant en informatique à Standford, dont les recherches portent sur l’impact sociétal de l’IA, en particulier sur celui des modèles de fondation au Center for Research on Foundation Models (CRFM), au sein de Stanford HAI, et Percy Liang, le directeur du centre, se sont entourés de chercheurs de Stanford, du MIT et de Princeton. Leur objectif est de contribuer à améliorer la transparence des modèles de fondation.

L’indice se base sur 100 indicateurs de transparence répartis en trois catégories : la construction des modèles (données, main-d’œuvre, ressources de calcul), les détails sur le modèle lui-même (comme son architecture, ses capacités ou ses risques) et l’utilisation en aval (par exemple, les mises à jour, les canaux de distribution, les politiques d’utilisation, les zones géographiques affectées).

Il vise à encourager un comportement plus responsable des entreprises. Pour certains indicateurs, un point est ainsi accordé à une entreprise qui ne divulgue pas les informations demandées, mais justifie les raisons pour lesquelles elles ne le sont pas.

Rishi Bommasani explique :

“L’indice ne se concentre pas intentionnellement sur la notation de la responsabilité des entreprises. Si une entreprise révèle que la formation de ses modèles nécessite beaucoup d’énergie, qu’elle ne paie pas un salaire décent à ses employés ou que ses utilisateurs en aval font quelque chose de nuisible, l’entreprise obtiendra toujours un point FMTI pour ces divulgations”.

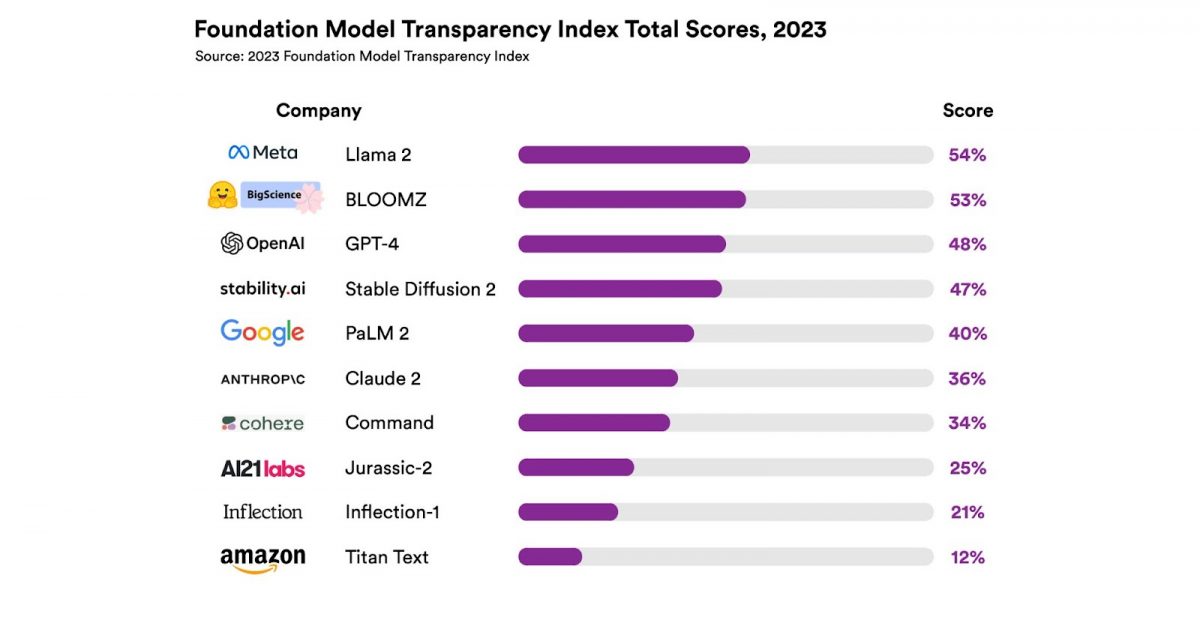

Les chercheurs ont noté les concepteurs en fonction de leurs pratiques pour leur modèle de fondation phare (GPT-4 pour OpenAI, PaLM 2 pour Google, Llama 2 pour Meta…).

Un manque de transparence évident

Si le modèle open source LLama 2 de Meta est le mieux noté, il n’obtient que 54 sur 100, ce qui révèle un manque fondamental de transparence de l’industrie de l’IA. BLOOMZ, le LLM open source développé dans le cadre du projet BigScience auquel a participé HuggingFace le talonne avec 53 sur 100 suivi par GPT-4 OpenAI qui obtient 48 sur 100.

Cependant, une des entreprises a obtenu 1 point pour 82 de ces indicateurs, ce qui, pour les chercheurs, démontre que les entreprises peuvent améliorer considérablement la transparence de leurs modèles en adoptant les meilleures pratiques de leurs concurrents.

Les concepteurs de modèles open-source ouvrent ainsi la voie puisqu’ils obtiennent les deux scores les plus élevés, le troisième, Stability AI est à la 4ème place, avec seulement 1 point de moins qu’OpenAI.

Si les entreprises sont pour la plupart transparentes sur la protection des données des utilisateurs et les fonctionnalités de base de leur modèle, aucune n’a fourni d’informations sur le nombre d’utilisateurs qui dépendent de son modèle ou des statistiques sur les zones géographiques ou les secteurs de marché qui utilisent son modèle. La plupart d’entre elles ne divulguent pas si elles ont utilisé des contenus protégés par le droit d’auteur comme données d’entraînement, et, si oui, dans quelle mesure, ni d’ailleurs leurs pratiques de travail.

Quel impact pour le FMTI ?

La plupart des entreprises évaluées se sont engagées en juillet dernier à soutenir le développement d’une IA responsable devant le gouvernement Biden, Rishi Bommasani espère que l’indice les incitera à tenir leurs promesses en augmentant la transparence.

Il espère également, qu’en mettant en évidence les lacunes des entreprises, il contribuera à éclairer l’élaboration des politiques par les gouvernements du monde entier, notamment à celle de l’AI Act.

Il déclare :

“Je pense que cela leur donnera beaucoup de clarté sur la configuration du terrain, sur ce qui est bon et mauvais dans le statu quo et sur ce qu’ils pourraient potentiellement changer avec la législation et la réglementation”.

L’équipe de chercheurs prévoit de continuer à mettre à jour l’indice FMTI, encourageant ainsi les entreprises à améliorer leur transparence dans le domaine des modèles de fondation.

Références de l’article : Blog HAI

Article de recherche : “The Foundation Model Transparency Index” arXiv :2310.12941v1, 19 octobre 2023

Auteurs :

- Rishi Bommasani, doctorant en informatique à Stanford et responsable de la société au CRFM de Stanford ;

- Kevin Klyman, étudiante à la maîtrise en politique internationale à Stanford ;

- Shayne Longpre, doctorante en arts et sciences médiatiques au MIT ;

- Sayash Kapoor, doctorant en informatique à Princeton ;

- Nestor Maslej, Directeur de recherche à Stanford HAI et rédacteur en chef de l’AI Index ;

- Betty Xiong, doctorant en informatique biomédicale à Stanford et boursier diplômé de l’IAH ;

- Daniel Zhang, Directeur principal des initiatives politiques à Stanford HAI et professeur agrégé d’informatique à Stanford ;

- Percy Liang, Directeur du CRFM de Stanford.