OpenAI présente MuseNet, une intelligence artificielle capable de générer des compositions musicales de 4 minutes, avec 10 instruments différents en combinant différents styles.

Si la musique fait principalement appel à la sensibilité de ses auditeurs, sa composition repose avant tout sur des règles mathématiques : gammes, accords, harmonies, cadences, structures, sont théorisés et codifiés. Pythagore lui même avait, en son temps, théorisé le rapport entre hauteur des notes et mathématiques. Car, bien plus que la fréquence absolue des notes, c’est le rapport entre celles-ci qui compte.

Le respect des règles de théorie musicale permet de s’assurer qu’une composition ne sera pas dissonante, qu’elle provoquera un certain type d’émotion et relèvera d’un style défini grâce au choix des instruments, gammes, mode et tempo. Il est toutefois possible de jouer avec ces règles et les contourner afin d’ajouter du relief aux compositions.

La musique se présente donc comme un candidat idéal à l’application de l’intelligence artificielle : sa capacité à détecter des motifs et structures, les entremêler, leur apporter de subtiles variations en fait un champ d’expérimentation infini.

Dans une publication sur le blog d’OpenAI, Christine Payne présente MuseNet.

Exemples de compositions réalisées par MuseNet :

Voici une composition générée à partir des 6 premières notes de l’Op. 10, No. 9 de Chopin.

Composition Jazz trio Piano Basse Percussions :

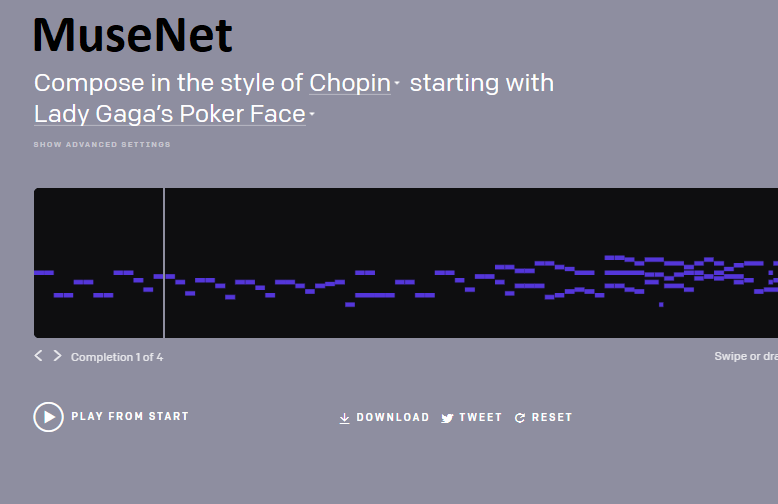

Le 12 mai, OpenAI proposera Co-compose, un outil permettant de générer des compositions “dans le style de” certains musiciens, en débutant avec les 5 premières notes de morceaux connus. (L’outil est d’ores et déjà testable sur le post d’OpenAI)

MuseNet repose sur un Sparse Transformer, réseau de neurones profonds capable de prédire la suite d’une séquence donnée, qu’il s’agisse de texte, son ou images. Il s’agit d’une version améliorée des mécanismes d’attention capable d’extraire des motifs de séquences jusqu’à 30 fois plus longs que ce qui était précédemment possible, toujours selon OpenAI.

Christine Payne explique sur le blog que la musique est très intéressante pour tester les Sparse Transformer puisque le traitement de la musique se situe à mi-chemin entre le traitement d’image et le traitement de texte : La musique a la structure libre du texte, contrairement aux grilles de pixels fixes des images qui s’enchainent un à une dans les séquences animées, mais il est aisé de remarquer si le modèle fait des erreurs dans la détection des structures et change de rythme.

Accéder au post original : https://openai.com/blog/musenet/