Intel organise ces 14 et 15 novembre sa première conférence développeurs dédiée à l'intelligence artificielle à Pékin. C'est à cette occasion que la firme vient de dévoiler son Neural Compute Stick 2 (NCS2). Une clef USB permettant de prototyper et déployer des algorithmes d'intelligence artificielle (deep Learning) "On the edge".

Une démocratisation du hardware destiné à l'IA

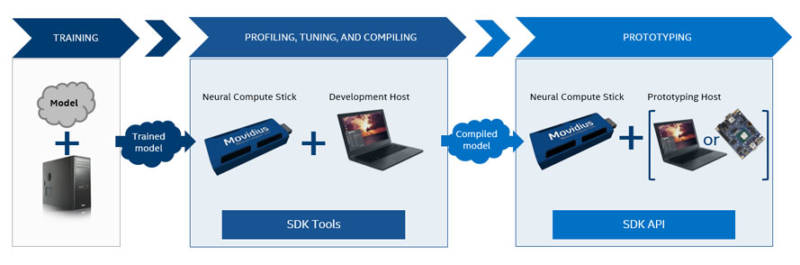

En lançant la première clef USB Movidius Neural Compute Stick en juillet 2017, Movidius, société du groupe Intel, avait marqué un grand coup en proposant le premier périphérique prêt à l'emploi et accessible destiné à faciliter la mise en oeuvre de projets d'IA.C'est à peine plus d'un an plus tard que les équipes d'Intel nous apprennent la sortie d'une nouvelle version, encore plus performante. Nous avons pu nous entretenir avec Steen Graham, Manager général de la verticale IoT chez Intel au sujet de ce nouveau modèle. Il a notamment pu nous confirmer que les modèles TensorFlow et Caffe sont supportés. Attention, les modèles doivent toutefois être compilés avant d'être utilisés.

L'ancienne version tout comme la nouvelle sont compatibles avec tout PC muni d'un port USB 3.0 et ne requièrent aucun autre matériel. Il est ainsi tout à fait possible de brancher le Neural Compute Stick 2 sur un simple Raspberry Pi pour tirer parti de ses performances de calcul. Ce stick, qui sera vendu 99 Dollars remplit donc parfaitement son objectif de démocratisation de l'IA.

L'ancienne version tout comme la nouvelle sont compatibles avec tout PC muni d'un port USB 3.0 et ne requièrent aucun autre matériel. Il est ainsi tout à fait possible de brancher le Neural Compute Stick 2 sur un simple Raspberry Pi pour tirer parti de ses performances de calcul. Ce stick, qui sera vendu 99 Dollars remplit donc parfaitement son objectif de démocratisation de l'IA.

"La première génération d'Intel Neural Compute Stick a poussé toute une communauté de développeurs en intelligence artificielle à passer à l'action avec un facteur de forme et un prix qui n'existaient pas auparavant. Nous sommes ravis de voir ce que la communauté va créer grâce à l'importante amélioration de la puissance de calcul rendue possible par le nouveau Intel Neural Compute Stick 2"

Naveen Rao, Vice président d'Intel et manager général de la verticale IA.

Des performances accrues

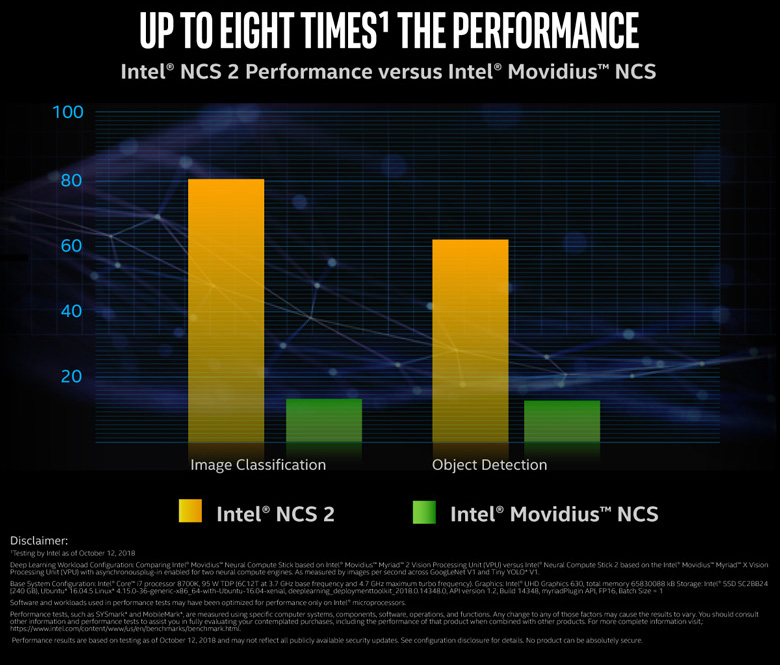

La nouvelle version du stick repose sur un VPU Intel Myriad X. Celui-ci dispose de 16 coeurs SHAVE. SHAVE est l'acronyme d'une technologie propriétaire (Streaming Hybrid Architecture Vector Engine) destinée à apporter le meilleur des monde entre GPUs, DSPs et RISC. Le NCS2 offre des performances jusqu'à 8 fois supérieures à son prédécesseur et est compatible avec le toolkit OpenVINO, ce qui en fait un outil particulièrement adapté à la vision artificielle. Le VPU Myriad X supporte d'ailleurs la vision stéréo 720p jusqu'à 180Hz.

La nouvelle version du stick repose sur un VPU Intel Myriad X. Celui-ci dispose de 16 coeurs SHAVE. SHAVE est l'acronyme d'une technologie propriétaire (Streaming Hybrid Architecture Vector Engine) destinée à apporter le meilleur des monde entre GPUs, DSPs et RISC. Le NCS2 offre des performances jusqu'à 8 fois supérieures à son prédécesseur et est compatible avec le toolkit OpenVINO, ce qui en fait un outil particulièrement adapté à la vision artificielle. Le VPU Myriad X supporte d'ailleurs la vision stéréo 720p jusqu'à 180Hz.

Il n'est bien sûr pas question d'entraîner de grands modèles avec ce stick USB, il est destiné à de l'inférence en temps réel. Il est possible de coupler plusieurs de ces sticks ensemble afin de combiner leur puissance de calcul.

Il n'est bien sûr pas question d'entraîner de grands modèles avec ce stick USB, il est destiné à de l'inférence en temps réel. Il est possible de coupler plusieurs de ces sticks ensemble afin de combiner leur puissance de calcul.

Un large éventail d'applications envisageables

De nombreux tutoriels ont été publiés par Intel pour le modèle précédent. Ces tutoriels devraient rester très largement valides pour le nouveau modèle. Intel présente sur son site différentes études de cas mettant en oeuvre le Neural Compute Stick : détection du cancer du sein, détection du cancer de la peau mais c'est avant tout dans les utilisations embarquées que le NCS2 trouvera toute sa force.Outre le prix et les performances, la faible consommation électrique du stick et son encombrement réduit (72.5 mm x 27 mm x 14 mm) en font le candidat idéal pour l'informatique embarquée et les objets connectés. Il permet de prototyper des caméras intelligentes, drones ou autres périphériques IoT.

Le Neural Compute Stick 2 devrait être disponible en commande dès aujourd'hui sur RS Components.

Les autres annonces de l'AI Devcon :

- Intel reviendra sur le processeur Intel Xeon Cascade Lake que nous vous présentions il y a quelques jours. Ce processeur intégrera des fonctions appelées DL Boost destinées à accélérer les tâches d'inférence Deep Learning et améliorer la reconnaissance d'image.

- Deux nouveaux produits Intel® Vision Accelerator Design : l'un basé sur des VPU Movidius et l'autre sur processeurs hautes performances ARRIA 10 FPGA.

- Enfin, Intel va présenter Spring Crest, processeur adapté aux calculs pour les réseaux de neurones, optimisé pour les multiplications de matrices denses et le parallélisme qui devrait être disponible sur le marché en 2019.