Les puces de NVIDIA, notamment le GPU H100, sont les plus utilisées que ce soit pour les datacenters, les supercalculateurs, l'entraînement ou l'inférence des LLM. Lors de la GTC 2024, qui a réuni Jensen Huang, fondateur et PDG de NVIDIA, a présenté des GPU qui devraient apporter encore plus de puissance de calcul : la puce "la plus puissante au monde pour l'IA" Blackwell B200 basée sur une nouvelle architecture et la super puce GB200, qui combinera les architectures Grace et Blackwell.

Nommée en l’honneur de David Harold Blackwell, mathématicien de l’Université de Californie à Berkeley spécialisé dans la théorie des jeux et les statistiques, et premier chercheur noir intronisé à l’Académie nationale des sciences, la nouvelle architecture succède à l’architecture NVIDIA Hopper, lancée il y a deux ans.

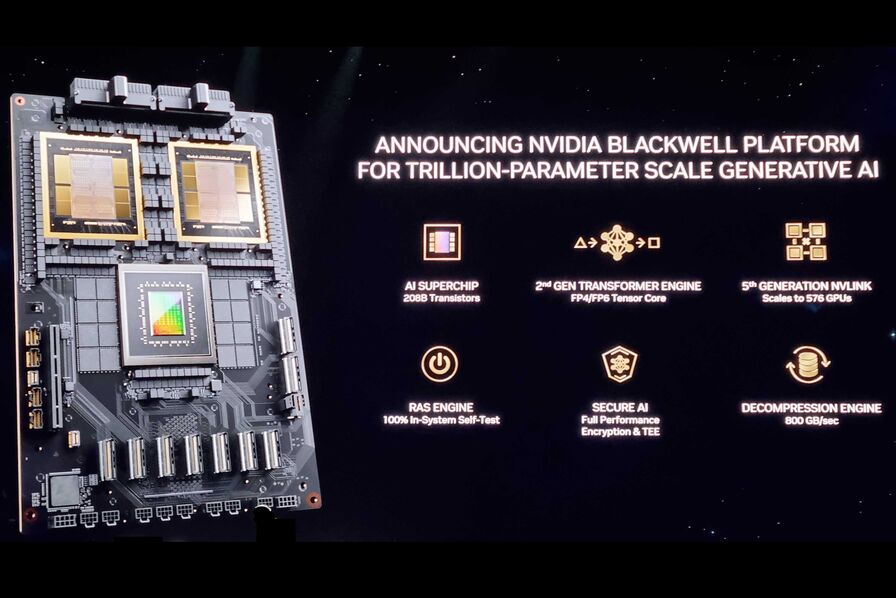

Elle comprend, selon NVIDIA, six technologies transformatrices pour l’informatique accélérée, qui contribueront à débloquer des percées dans le traitement des données, la simulation d’ingénierie, l’automatisation de la conception électronique, la conception de médicaments assistée par ordinateur, l’informatique quantique et l’IA générative, autant d’opportunités industrielles émergentes pour NVIDIA.

Outre les puces Blackwell, elle dispose notamment d'un moteur de transformateur de deuxième génération : alimentée par une nouvelle prise en charge de la mise à l’échelle des micro-tenseurs et les algorithmes avancés de gestion de la plage dynamique de NVIDIA intégrés aux frameworks NVIDIA TensorRT-LLM et NeMo Megatron, Blackwell prendra en charge le double de la taille des calculs et des modèles avec de nouvelles capacités d’inférence IA en virgule flottante 4 bits.

Un NVLink de cinquième génération permet d'accélérer les performances des modèles d’IA de plusieurs billions de paramètres grâce à un débit bidirectionnel de 1,8 To/s par GPU, garantissant une communication haut débit transparente entre jusqu’à 576 GPU pour les LLM les plus complexes.

[caption id="attachment_56580" align="aligncenter" width="896"] Crédit Nvidia[/caption]

Crédit Nvidia[/caption]

Blackwell multiplie les performances de Hopper par 2,5 en FP8 pour l’entraînement, par puce et par 5 avec FP4 pour l’inférence.

Lors de son discours d'ouverture, Jensen Huang affirmait:

"Pendant trois décennies, nous avons poursuivi l’informatique accélérée, dans le but de permettre des percées transformatrices telles que l’apprentissage profond et l’IA. L’IA générative est la technologie déterminante de notre époque. Blackwell est le moteur de cette nouvelle révolution industrielle. En travaillant avec les entreprises les plus dynamiques au monde, nous réaliserons les promesses de l’IA pour tous les secteurs".

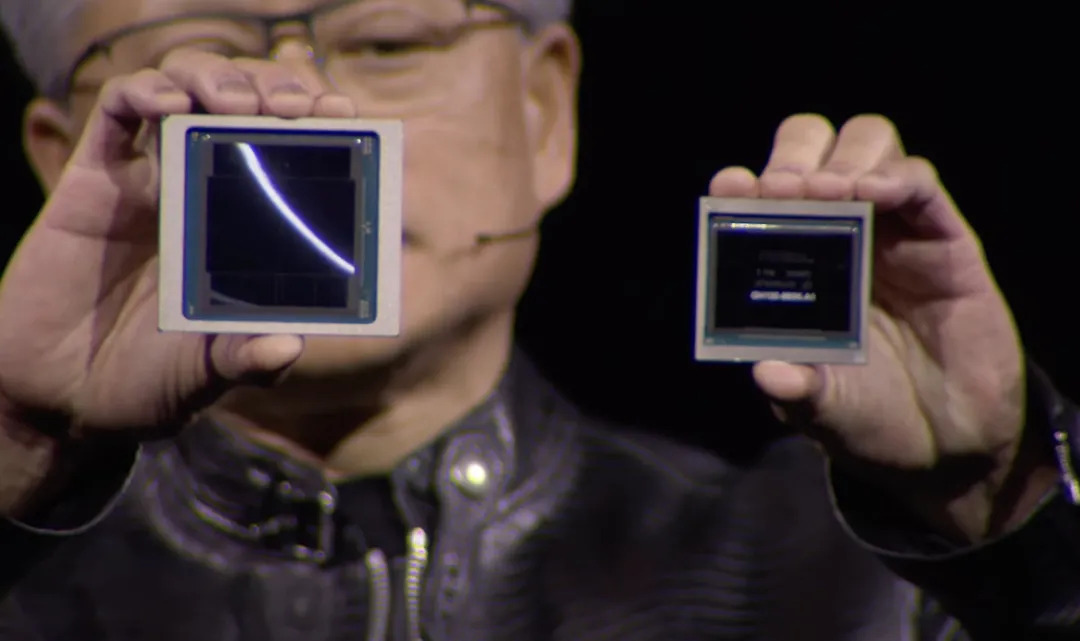

Le GPU B200 et la superpuce GB200

Comptant deux cœurs de processeur, chacun comportant 104 milliards de transistors, les GPU d’architecture Blackwell sont fabriqués à l’aide d’un processus TSMC 4NP sur mesure avec des puces GPU limitées à deux réticules connectées par une liaison puce à puce de 10 To/seconde formant ainsi un seul GPU unifié. Tout comme les GH200 Grace Hopper, les B200 sont dotés de mémoire HBM3e, (192 pour ces derniers contre 282 Go pour le GH200),qui permet de gérer les charges de travail d’IA générative les plus complexes, allant des grands modèles linguistiques aux systèmes de recommandation et aux bases de données vectorielles. La bande passante mémoire est de 8 To/s.[caption id="attachment_56581" align="aligncenter" width="1080"] Crédit NVIDIA : à gauche GB200, à droite le gpu H100[/caption]

Crédit NVIDIA : à gauche GB200, à droite le gpu H100[/caption]

La superpuce GB200 connecte deux de ces GPU B200 à un processeur Grace, via une interconnexion puce-puce NVLink ultra-basse consommation de 900 Go/s, pour offrir des performances 30 fois supérieures pour les calculs d’inférence. Selon Jensen Huang, la formation d’un modèle de 1 800 milliards de paramètres aurait auparavant nécessité 8 000 GPU Hopper et 15 mégawatts de puissance, 2 000 GPU Blackwell permettent de le faire en ne consommant que quatre mégawatts.

Le GB200 serait également 25 fois plus performant en matière d'efficacité énergétique que le H 100.

[caption id="attachment_56582" align="aligncenter" width="1080"] Crédit NVIDIA Le GB200 NVL72[/caption]

Crédit NVIDIA Le GB200 NVL72[/caption]

Le GB200 est un composant clé du NVIDIA GB200 NVL72, un système multi-nœuds, refroidi par liquide et à l’échelle du rack pour les charges de travail les plus gourmandes en ressources de calcul. Il combine 36 superpuces Grace Blackwell, dont 72 GPU Blackwell et 36 CPU Grace interconnectés par le NVLink de cinquième génération. Grâce à lui, l’inférence d'un LLM de mille milliards de paramètres serait 30 fois plus rapide.