Lors de sa conférence Google I/O 2023, la firme a notamment présenté PaLM 2 et déclaré travailler sur Gemini, son prochain modèle multimodal. Sundar Pichai, lors de l'édition 2024 qui s'est déroulée ce mardi 14 mai, annonce "l'ère Gemini" avec l'intégration du modèle à la recherche, Workspace, Photos, Android 15, au futur assistant d'IA multimodal "Project Astra" de DeepMind, des mises à jour pour les modèles de la famille et l'ajout de 1.5 Flash, un modèle plus léger.

Google a également présenté Veo, un modèle de génération vidéo et Imagen 3, la dernière itération de son modèle text-to-image, le modèle open-source Gemma 2 ainsi que Trillium, sa 6e génération de TPU.

L'annonce la plus importante de la keynote a toutefois été celle de l'intégration de Gemini à son moteur de recherche.

Google Search : une expérience de recherche améliorée avec AI Overviews

Google a intégré un modèle Gemini personnalisé à son moteur de recherche, rendant ainsi l'expérience de recherche plus simple et interactive.Les aperçus d'IA, introduits par Google l'an passé dans son programme Search Labs et qui auraient été utilisés des milliards de fois depuis, peuvent apporter des réponses rapides. Un résumé est généré, suivi de liens pour approfondir. Lorsqu'on veut obtenir une réponse plus simple, si on est profane sur un sujet ou si l'on veut une réponse plus adaptée à un enfant, il suffit de cliquer sur les boutons prévus pour simplifier le niveau de langage de l'aperçu ou obtenir un résumé plus détaillé.

Grâce aux capacités de raisonnement en plusieurs étapes du modèle, il est désormais possible d'entrer une requête complexe plutôt que de faire une recherche en plusieurs étapes.Liz Reid, vice-présidente et responsable de Google Search, donne l'exemple suivant "trouvez les meilleurs studios de yoga ou de Pilates à Boston et montrez-moi des détails sur leurs offres d’introduction et le temps de marche depuis Beacon Hill".

Grâce à ses capacités de planification, on lui peut demander de générer un itinéraire de voyage ou des idées de repas pour plusieurs jours et exporter ses réponses vers Docs ou Gmail.

Le déploiement d'AI Overviews a débuté aux États-Unis, il sera disponible dans d'autres pays dès cette année.

Poser des questions avec une vidéo

Il sera bientôt possible d'utiliser une vidéo pour demander de l'aide à l'IA. L'application Google Lens qui permet d'avoir des informations à partir d'une photo permettra d'effectuer une recherche à partir d'une vidéo.Liz Reid donne l'exemple suivant :

"Peut-être avez-vous acheté un tourne-disque dans une friperie, mais il ne fonctionne pas lorsque vous l’allumez et que la pièce métallique avec l’aiguille dérive de manière inattendue. La recherche vidéo vous évite de trouver les bons mots pour décrire ce problème, et vous obtiendrez une vue d’ensemble de l’IA avec les étapes et les ressources à résoudre".

https://twitter.com/i/status/1790440001156583712

La recherche vidéo sera bientôt disponible pour les utilisateurs de Search Labs aux États-Unis.

Gemini dans android 15

Google Assistant va être remplacé sur Android par Gemini. Bientôt, les utilisateurs pourront utiliser Gemini de manière plus interactive en le superposant dans une fenêtre au-dessus des applications. Il sera possible de faire glisser et déposer des images générées dans Gmail, Google Messages et d’autres endroits, ou appuyer sur « Demander cette vidéo » pour trouver des informations spécifiques dans une vidéo YouTubeGemini Nano, le modèle utilisé sur Android, a été mis à jour et peut désormais traiter des entrées multimodales telles que les images, les sons et le langage parlé. Il sera disponible un peu plus tard dans l'année.

TalkBack utilisera les capacités multimodales de Gemini Nano pour fournir des descriptions plus détaillées de ce qui se trouve dans les images, améliorant ainsi l'accessibilité pour les personnes aveugles ou malvoyantes. De plus, une nouvelle fonctionnalité en cours de test utilisera Gemini Nano pour détecter les escroqueries potentielles lors d'appels téléphoniques et fournir des alertes en temps réel aux utilisateurs.

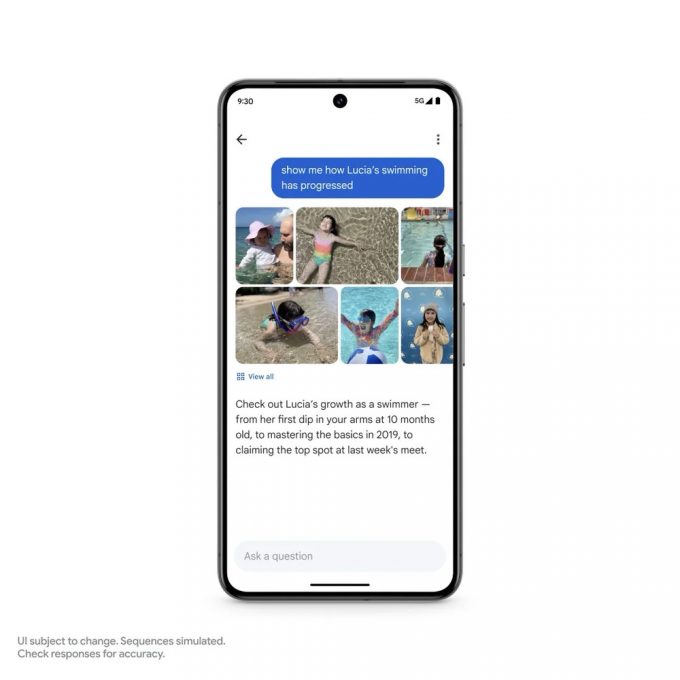

Ask photos

Il sera possible de retrouver des photos dans Google Photos non plus à partir de mots-clés, mais de demandes textuelles. Sundar Pichai donne l'exemple suivant : "Par exemple, vous vous souvenez peut-être des premières étapes importantes de votre fille Lucia. Maintenant, vous pouvez demander à Photos : « Quand Lucia a-t-elle appris à nager ? »Et vous pouvez poursuivre avec quelque chose d’encore plus complexe : « Montrez-moi comment la natation de Lucia a progressé. »

Ici, Gemini va au-delà d’une simple recherche, reconnaissant différents contextes - des longueurs dans la piscine à la plongée en apnée dans l’océan, en passant par le texte et les dates de ses certificats de natation"

Ask Photos sera déployé cet été, avec d’autres fonctionnalités à venir.

Mises à jour de la famille Gemini

Outre l'extension de Gemini Nano pour inclure des entrées multimodales au-delà du texte, utilisable sur Android via Pixel, Google annonce des améliorations significatives de Gemini 1.5 Pro dans la génération de code, le raisonnement logique, et la compréhension de l’audio et de l’image. Sa fenêtre contextuelle peut être étendue jusqu'à 2 millions de jetons.Il a également présenté Flash 1.5, le dernier ajout à la famille Gemini, un modèle léger optimisé pour la vitesse et l'efficacité. Selon Demis Hassabis, PDG de Google DeepMind, ce dernier modèle excelle dans le résumé, les applications de chat, le sous-titrage d’images et de vidéos, l’extraction de données à partir de longs documents et tableaux, etc. Ce qu'il explique par le fait qu'il a été entraîné par 1.5 Pro par le biais d’un processus appelé « distillation », où les connaissances et les compétences les plus essentielles d’un modèle plus grand sont transférées vers un modèle plus petit et plus efficace.

Google a présenté en février dernier Gemma, une famille de modèles légers de pointe conçus à partir des mêmes recherches et technologies que celles utilisées pour créer les modèles Gemini, les plus performants de la firme. Il annonce Gemma 2, sa nouvelle génération de modèles ouverts, avec une nouvelle architecture ainsi que PaliGemma, notre premier modèle de langage visuel inspiré de PaLI-3.

Vers des assistants universels

Pour Google Deepmind, les assistants d'IA évolueront pour devenir utiles au quotidien. Son objectif est de développer des assistants qui ne se contentent pas de répondre aux commandes, mais qui comprennent également le contexte visuel et peuvent répondre de manière proactive et conversationnelle. Selon Demis Hassabis, "réduire le temps de réponse à quelque chose de conversationnel est un défi d’ingénierie difficile".Il explique la démarche de l'équipe :

"En nous appuyant sur Gemini, nous avons développé des prototypes d’agents capables de traiter les informations plus rapidement en encodant en continu les images vidéo, en combinant les entrées vidéo et vocales dans une chronologie des événements et en mettant en cache ces informations pour un rappel efficace".

Il partage une démonstration en deux parties du projet Astra, chacune d'elles ayant été capturée en une seule prise, en temps réel.