Facebook AI Research (FAIR), le laboratoire de recherche sur l'intelligence artificielle de Facebook, a travaillé sur BlenderBot 2.0, un chatbot qui combine mémoire à long terme et informations récupérées en direct sur internet. Il s'agit d'une mise à jour importante du Blender Bot original qui avait déjà été conçu en 2020 et qui était connu pour prendre en compte plus de paramètres que des chatbots plus classiques comme la personnalité, l'empathie ou la culture. L'outil a été publié en open source.

Un chatbot qui reste à jour dans un monde en constante évolution

Il y a environ un an, Facebook a détaillé ses travaux sur un chatbot IA appelé BlenderBot 1.0, qui, selon la firme, est le plus grand projet de ce type jamais réalisé. Dans le prolongement de ce travail, Facebook a aujourd'hui dévoilé BlenderBot 2.0, capable de combiner mémoire à long terme et informations "fraiches" provenant d'internet.L'objectif des chercheurs du FAIR est donc de faire en sorte que le modèle qu'ils proposent reste à jour dans un monde qui est constamment en train d'évoluer et où les choses établies la veille (ou à la date de constitution du jeu de données d'entraînement !) ne sont plus d'actualités le lendemain. Ce que ne permettent pas nativement GPT-3 ou la première version de BlenderBot.

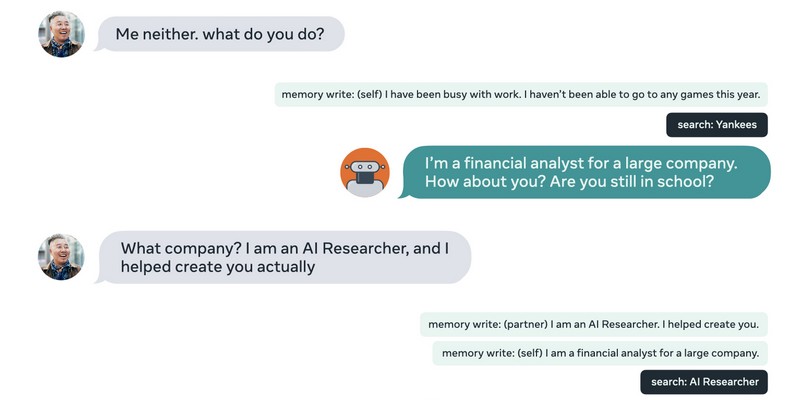

Ainsi, le chatbot retient des informations au fil de ses différents échanges avec ses interlocuteurs ( dans une zone de sa mémoire spécifique à chaque interlocuteur) et peut parallèlement récupérer des informations contextuelles sur internet en temps-réel, afin de produire des échanges riches. La combinaison de ces deux fonctions permettant d'entrevoir la création d'assistants virtuels toujours plus personnalisés.

Des capacités de conversations basé sur la génération de récupération augmentée

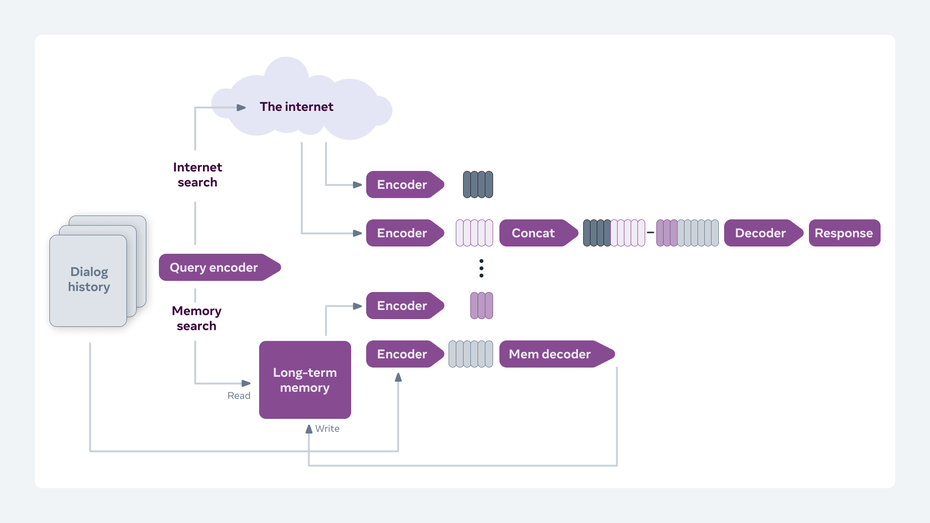

BlenderBot 2.0 utilise un modèle d'IA basé sur la génération de récupération augmentée, une approche qui permet de générer des réponses et d'incorporer des connaissances au-delà de celles contenues dans une conversation. Au cours d'un dialogue, le modèle, qui combine un composant de recherche d'informations avec un générateur de texte, recherche des données pertinentes à la fois dans sa mémoire à long terme et dans les documents qu'il trouve en cherchant sur Internet.Le réseau de neurones exploité par ce nouvel outil produit des recherches dans un contexte de conversation. Le chatbot ajoute les connaissances qu'il a récupéré dans l'historique des conversations précédentes entre lui et l'utilisateur puis prend en compte les connaissances actuelles du monde à l'instant T pour décider de ce qu'il va répondre à l'utilisateur.

Pour entrainer le modèle, Facebook a collecté des données en anglais à l'aide d'une plate-forme de crowdsourcing similaire à Amazon Mechanical Turk. Un de ces ensembles du nom de Wizard of the Internet comporte des conversations entre êtres humains améliorés à l'aide de nouvelles informations provenant de recherches sur Internet. Un autre, intitulé Multisession, possède des conversations sur le long terme entre utilisateurs et référence les informations passées.

Quid du futur ?

Un problème qu'ont relevé les chercheurs concerne la sécurité. Jason Weston, chercheur pour Facebook, ainsi que Kurt Shuster, ingénieur de recherche, se sont exprimés sur le sujet :"Nous savons que les problèmes de sécurité ne sont pas encore résolus, et l'approche de BlenderBot 2.0 consistant à utiliser Internet et la mémoire à long terme pour ancrer les réponses conversationnelles pose de nouveaux défis en matière de sécurité. En tant que communauté de recherche, nous devons les aborder, et nous pensons que des recherches reproductibles sur la sécurité, rendues possibles par des rejets comme celui-ci, aideront la communauté à faire ensemble de nouveaux progrès importants dans ce domaine."Outre le problème de la sécurité, Facebook précise que BlenderBot 2.0 est meilleur que BlenderBot 1.0 lorsqu'il s'agit de reprendre en cours une conversation qui s'était arrêtée par le passé, avec une amélioration de 17 % de l'engagement et de 12 % sur la cohérence des propos. Des résultats encourageants, mais qui ne donnent pas totale satisfaction aux deux experts :

"Tant que les modèles n’auront pas une compréhension plus profonde, ils se contrediront parfois. De même, nos modèles ne peuvent pas encore pleinement comprendre ce qui est sûr ou non. Et bien qu'ils construisent une mémoire à long terme, ils n'apprennent pas vraiment, ce qui signifie qu'ils ne s'améliorent pas sur leurs erreurs… Nous attendons avec impatience le jour où les agents construits pour communiquer et comprendre comme les humains pourront voir aussi bien que parleR."L'approche multimodale est en effet l'un des principaux leviers actuels pour améliorer la perception du monde des agents intelligents. (cf Interview de Cordelia Schmid - ActuIA N°5 )