Des chercheurs du MIT, de Princeton et de l'Université de Stanford ont publié la semaine dernière une lettre ouverte demandant aux entreprises d’IA de fournir des protections juridiques et techniques pour la recherche de bonne foi sur leurs modèles d’IA générative. Soulignant l’importance de l’évaluation et du red teaming indépendants pour identifier les risques des systèmes d’IA génératifs, elle a recueilli aujourd'hui plus de 300 signatures de chercheurs en IA, juristes, éthiciens, sociologues et défenseurs de différentes disciplines.

Shayne Longpre, Sayash Kapoor, Kevin Klyman, Ashwin Ramaswami, Rishi Bommasani, Arvind Narayanan, Percy Liang et Peter Henderson sont les auteurs de la lettre ouverte "A Safe Harbor for independant AI Evaluation" basée sur l'article de recherche "A Safe Harbor for AI Evaluation and Red Teaming" auxquels ils ont concouru avec 15 autres auteurs.

L’évaluation indépendante des modèles d’IA générative déjà déployés est d’une importance primordiale pour assurer la sûreté, la sécurité et la confiance. Des études ont révélé des vulnérabilités diverses, allant des problèmes liés à la sécurité aux biais algorithmiques, notamment sociaux, en passant par les questions de droits d’auteur. Cependant, seuls un nombre restreint de chercheurs sélectionnés par les entreprises ont accès à cette évaluation, créant ainsi une inégalité dans l’accès à l’information critique.

Les auteurs de la lettre déclarent dans un billet de blog :

"Malgré la nécessité d’une évaluation indépendante, la recherche liée à ces vulnérabilités est souvent interdite par la loi par les conditions d’utilisation des modèles d’IA populaires, notamment ceux d’OpenAI, de Google, d’Anthropic, d’Inflection, de Meta et de Midjourney. Bien que ces termes soient destinés à dissuader les acteurs malveillants, ils restreignent également par inadvertance la recherche sur la sécurité et la fiabilité de l’IA".

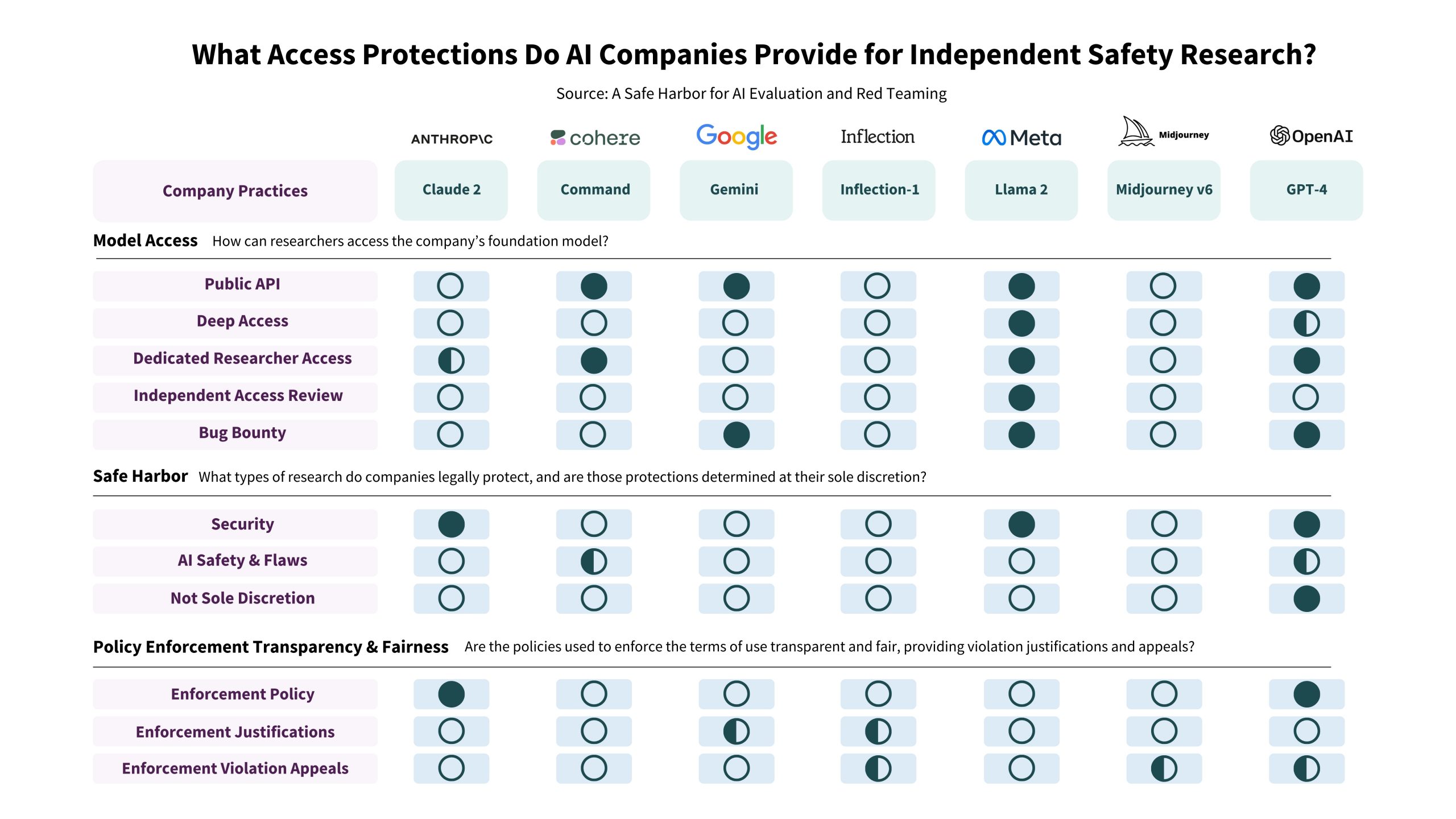

Pour eux, même si les entreprises appliquent ces restrictions à des degrés divers, les conditions peuvent décourager la recherche de bonne foi en accordant aux développeurs le droit de résilier les comptes des chercheurs ou même d’intenter une action en justice contre eux.Dans le tableau ci-dessous, ils mettent en évidence les lacunes dans les politiques d' OpenAI, Google, Cohere, Anthropic, Inflection, Meta et Midjourney, qui, selon eux, "obligent les chercheurs bien intentionnés à attendre l’approbation des programmes d’accès des chercheurs qui ne répondent pas, ou à risquer d’enfreindre la politique de l’entreprise et de perdre l’accès à leurs comptes".

Ils soulignent toutefois que Cohere et OpenAI sont des exceptions, "bien qu’une certaine ambiguïté subsiste quant à la portée des activités protégées".

[caption id="attachment_56319" align="alignnone" width="2560"] Ce tableau représente la mesure dans laquelle les entreprises offrent : l’accès à leurs modèles phares ; la sphère de sécurité pour la recherche externe en matière de sécurité, de sûreté et de fiabilité ; et la transparence et l’équité dans l’application de leurs politiques. Un cercle transparent signifie que l’entreprise n’offre pas l’accès à son modèle ou à sa sphère de sécurité de cette manière, ou qu’elle n’est pas transparente sur la manière dont elle applique ses politiques. Un cercle à moitié rempli indique un accès partiel, une sphère de sécurité ou une transparence, et deux cercles remplis indiquent un accès substantiel, une sphère de sécurité et une transparence.[/caption]

Ce tableau représente la mesure dans laquelle les entreprises offrent : l’accès à leurs modèles phares ; la sphère de sécurité pour la recherche externe en matière de sécurité, de sûreté et de fiabilité ; et la transparence et l’équité dans l’application de leurs politiques. Un cercle transparent signifie que l’entreprise n’offre pas l’accès à son modèle ou à sa sphère de sécurité de cette manière, ou qu’elle n’est pas transparente sur la manière dont elle applique ses politiques. Un cercle à moitié rempli indique un accès partiel, une sphère de sécurité ou une transparence, et deux cercles remplis indiquent un accès substantiel, une sphère de sécurité et une transparence.[/caption]

Selon les chercheurs, entraver les recherches indépendantes n’est pas dans l’intérêt des entreprises d’IA. Pour que la recherche indépendante sur l’IA puisse se dérouler dans un environnement favorable, sans crainte de représailles, ils demandent aux entreprises d’IA de fournir une sphère de sécurité établissant des normes minimales de protection juridique et technique pour protéger la recherche d'intérêt public.

Ils estiment que ces protections amélioreraient considérablement les normes écosystémiques et favoriseraient des efforts communautaires plus inclusifs et sans entrave pour lutter contre les risques de l’IA générative.