Dans une publication sur arXiv, des chercheurs du MIT et de l'Université de Harvard ont présenté Deep Evidential Regression, une intelligence artificielle qui serait « consciente » de sa propre fiabilité et de ses propres incertitudes et erreurs. Formée à partir de réseaux de neurones, elle propose des décisions et est également capable de mesurer l'incertitude de ces dernières.

Comme l'indiquent les chercheurs Alexander Amini, Wilko Schwarting et Ava Soleimany, Daniela Rus sur arXiv, les réseaux de neurones déterministes sont de plus en plus déployés dans des domaines critiques pour la sécurité, où des mesures d'incertitude calibrées, robustes et efficaces sont cruciales.

Dans leur article, ils proposent une nouvelle méthode pour la formation des réseaux de neurones non bayésiens pour estimer une cible continue ainsi que ses preuves associées afin d'apprendre à la fois l'incertitude aléatoire et épistémique. Ils sont parvenus à ce résultat en en plaçant des priors de preuve sur la fonction de vraisemblance gaussienne originale et en entraînant les réseaux de neurones à déduire les hyperparamètres de la distribution de preuve.

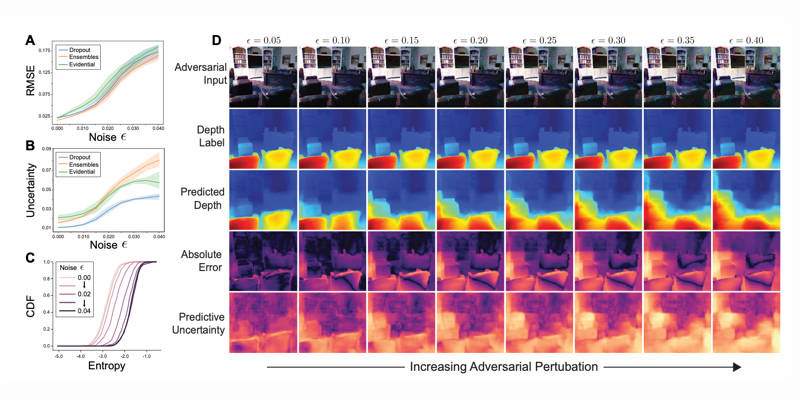

Ils ont également imposé des priors pendant l'apprentissage de sorte que le modèle soit régularisé lorsque ses preuves prédites ne sont pas alignées sur la sortie correcte. Leur méthode ne repose pas sur l'échantillonnage lors de l'inférence ou sur des exemples hors distribution (OOD) pour la formation des algorithmes, permettant ainsi un apprentissage efficace et évolutif de l'incertitude. Les chercheurs ont démontré l'apprentissage de mesures bien calibrées de l'incertitude sur divers points de repère, la mise à l'échelle vers des tâches de vision par ordinateur complexes, ainsi que la robustesse aux échantillons de test contradictoires et OOD.

Les chercheurs ont indiqué avoir testé leur intelligence artificielle avec succès. Pour cela, comme on peut le lire dans leur publication, ils lui ont présenté une image et elle devait juger les profondeurs dans différentes parties de celle-ci. Leur algorithme a signalé quand elle n'était pas capable de juger avec préciser certaines images qui sortaient de ses attributions habituelles.