La CVPR (Conference on Computer Vision and Pattern Recognition) est l’un des évènements les plus renommés et attendus dans le domaine de la vision par ordinateur, mais aussi dans celui de l’IA. La semaine dernière, Qualcomm y a présenté ses dernières avancées, notamment ControlNet, un modèle de vision du langage (LVM) image-à-image fonctionnant sur un téléphone et comptant 1,5 milliard de paramètres. Lors de la démonstration, les images générées par l’IA ont été créées sur l’appareil mobile en moins de 12 secondes.

L’IA générative peut désormais fonctionner non seulement dans des clouds de proximité (edge computing), mais aussi sur les smartphones disposant de suffisamment de puissance de calcul. Au lieu de dépendre d’une connexion Internet constante pour interagir avec des applications d’IA génératives, les utilisateurs peuvent maintenant profiter de ces fonctionnalités directement sur leur appareil, de manière autonome et privée.

Cela est rendu possible grâce à des avancées majeures dans l’optimisation des modèles d’IA, des logiciels et des accélérateurs matériels neuronaux. Chercheurs et ingénieurs travaillent sur l’efficacité des modèles, en réduisant leur taille et leur complexité, tout en conservant des performances élevées.

Qualcomm AI research a réalisé des optimisations par quantification, compilation et accélération matérielle à l’aide de Qualcomm AI Stack qui lui ont permis de déployer pour la 1ère fois le LLM Stable Diffusion sur un téléphone Android alimenté par la plateforme mobile Snapdragon 8 Gen 2, cette recherche a d’ailleurs été acceptée à la CVPR 2023.

Pour réduire le modèle open source FP32 version 1-5 de Hugging Face, l’équipe a utilisé la quantification post-formation de l’outil AI Model Efficiency Toolkit (AIMET). La quantification augmente non seulement les performances, mais permet également d’économiser de l’énergie en permettant au modèle de fonctionner efficacement.

Le résultat de cette optimisation full-stack est l’exécution de Stable Diffusion sur un smartphone en moins de 15 secondes pendant 20 étapes d’inférence pour générer une image de 512×512 pixels.

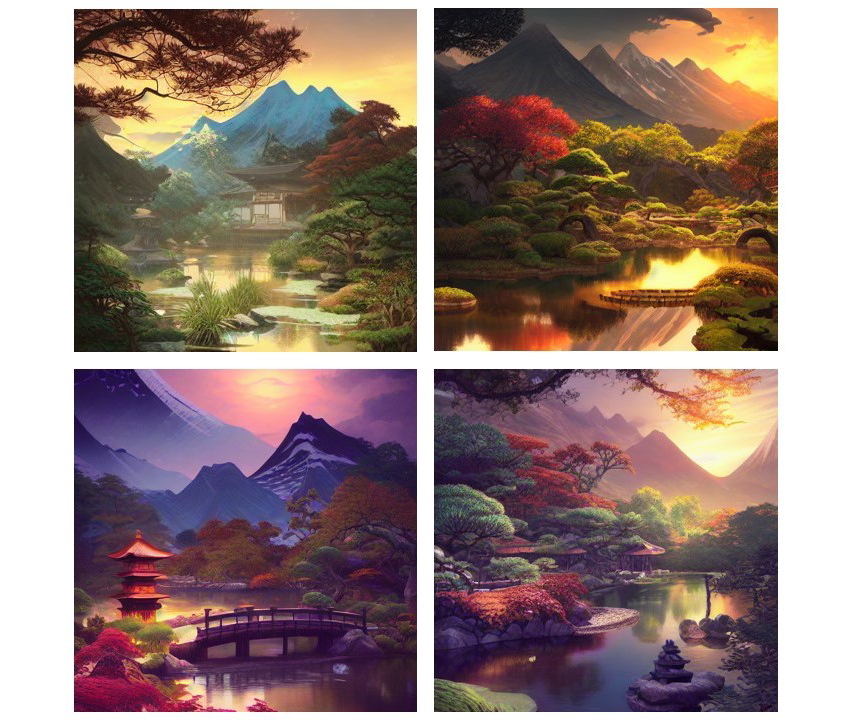

Images de diffusion stable générées avec l’invite : « Jardin japonais à la rivière de la faune et de la chaîne de montagnes, très détaillé, illustration numérique, artstation, concept art, mat, mise au point nette, illustration, dramatique, coucher de soleil, pierre de foyer, art par Artgerm et Greg Rutkowski et Alphonse Mucha. »

Les images étaient générées en moins de 14,5 secondes :

Générer des images en moins de 12 secondes

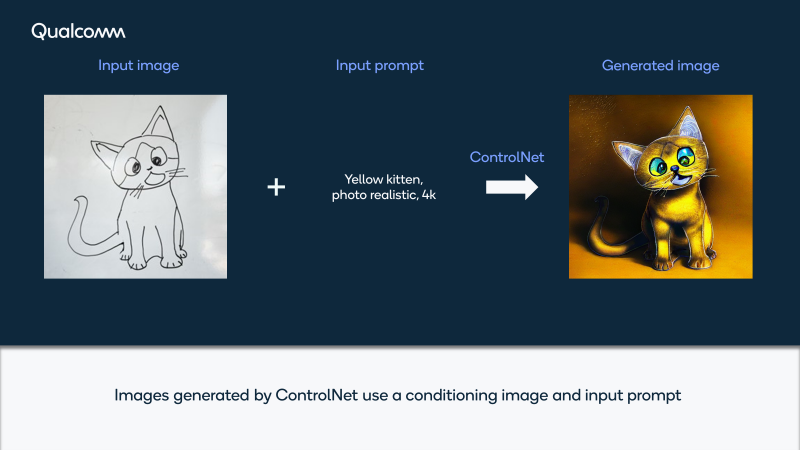

Qualcomm AI Research a fait à la CVPR la démonstration de ControlNet, un modèle image-à-image de 1,5 milliard de paramètres, fonctionnant également entièrement sur un téléphone. Il permet un contrôle plus précis de la génération d’images en conditionnant une image d’entrée et une description de texte d’entrée. Dans cette démo, les images d’IA sont générées sur l’appareil mobile en moins de 12 secondes sans avoir besoin d’accès à internet ou au cloud, ce qui, d’après les chercheurs, permet une expérience utilisateur interactive efficace, agréable, fiable et privée.

Lors de leur présentation, les chercheurs ont téléchargé un croquis de base d’un chaton, ont ajouté le prompt “chaton jaune, photoréaliste, 4k”.

Les images sont désormais générées en 16 étapes et moins de 12 secondes, comme vous pouvez le voir dans cette vidéo :

Pour Qualcom AI research, “exécuter Stable Diffusion sur un smartphone n’est que le début”. Les optimisations apportées au LLM peuvent également être utilisées pour d’autres plateformes telles que les ordinateurs portables, les casques XR et pratiquement tout autre appareil alimenté par Qualcomm Technologies.