Ann Johnson, alors professeur de mathématiques au Canada, a subi un AVC en 2005 qui l'a laissée totalement paralysée. Des chercheurs de l’Université de Californie à San Francisco (UCSF), en collaboration avec des collègues de l’Université de Californie à Berkeley, lui permettent aujourd'hui de communiquer via un implant cérébral et un avatar sur ordinateur.

Atteinte du "locked-in syndrome" à la suite de cet AVC, Ann Johnson a peu à peu retrouvé, après des années de rééducation, un peu de mouvement et d’expression faciale, peut à nouveau manger, à condition que les aliments soient hachés finement ou très mous, mais est incapable de parler.

En 2021, elle a entendu parler des travaux sur l'interface cerveau-machine de l'équipe du Dr Edward Chang, Président de la chirurgie neurologique à l'USCF. Elle a lu l’étude concernant une "neuroprothèse de la parole" qui traduisait les signaux cérébraux d'un homme incapable de parler, tout comme elle, à la suite d'un AVC, en texte sur un écran.

L'équipe était à la recherche de participants pour poursuivre leurs travaux et c'est avec enthousiasme qu'elle a collaboré avec eux. Les résultats de cette étude ont été publiés dans Nature le 23 août dernier.

L'IA et le deep learning pour décoder les données cérébrales

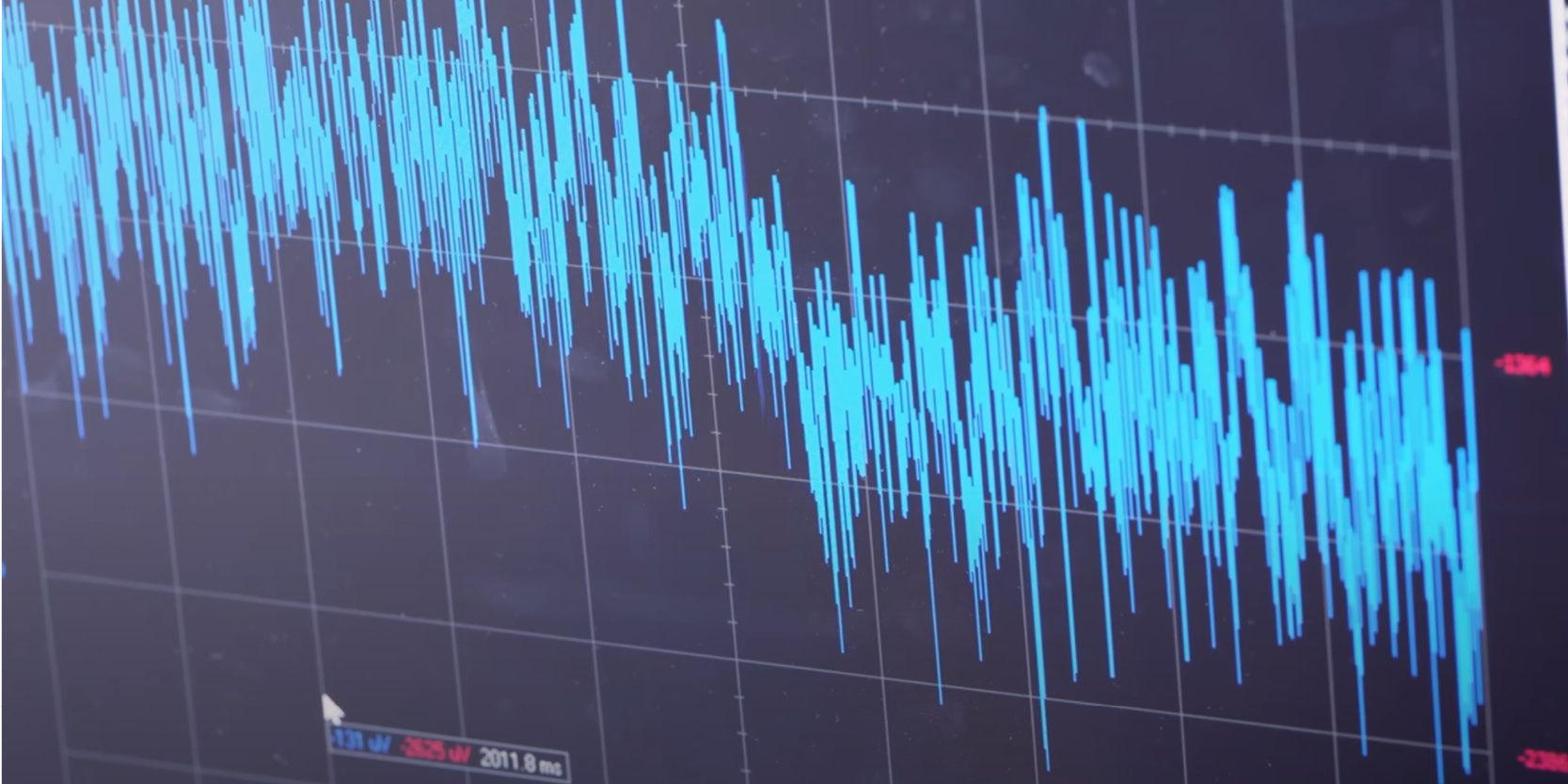

Pour Ann Johnson, l'équipe du Dr Chang et les chercheurs de l’Université de Californie à Berkeley sont allés beaucoup plus loin. Ils ont voulu également décodé les mouvements qui animent le visage d’une personne pendant la conversation.Ils ont implanté un dispositif mince comportant 253 électrodes sur la surface du cerveau d'Ann, sur les zones qu'ils avaient identifiées comme critiques pour la parole. Ces électrodes, reliées à une banque d’ordinateurs par un câble, ont capturé les signaux cérébraux qui auraient normalement activé les muscles de la parole et du visage.

Pendant plusieurs semaines, Ann a travaillé avec l'équipe pour entraîner les algorithmes d'apprentissage profond à reconnaître ses signaux cérébraux associés à la parole. Pour cela, elle a répété inlassablement différentes phrases d'un vocabulaire de 1 024 mots jusqu’à ce que l’ordinateur reconnaisse les modèles d’activité cérébrale associés à chaque son de base de la parole.

Plutôt que d'enseigner à l'IA à reconnaître des mots entiers, l'équipe a utilisé un système basé sur la reconnaissance de phonèmes, les composants de base de la parole. Cela a permis au décodeur de déchiffrer n'importe quel mot en anglais en se basant sur seulement 39 phonèmes, ce qui a amélioré la précision et la vitesse du système.

Sean Metzger, qui a développé le décodeur de texte avec Alex Silva, comme lui étudiant diplômé du programme conjoint de bio-ingénierie de l’UC Berkeley et de l’UCSF, explique :

"La précision, la vitesse et le vocabulaire sont cruciaux. C’est ce qui donne à Ann le potentiel, avec le temps, de communiquer presque aussi vite que nous le faisons, et d’avoir des conversations beaucoup plus naturalistes et normales".

Ajouter une voix et un visage

Pour recréer la voix d’Ann, l’équipe a utilisé l'enregistrement d'un discours qu'elle avait prononcé lors de son mariage et développé un algorithme de synthèse de la parole.Pour que l'interaction soit plus réaliste, Ann s'est choisi un avatar que l'équipe a un animé à l'aide d'un logiciel qui simule les mouvements musculaires du visage, développé par Speech Graphics.

Un énorme espoir pour les personnes privées de l'usage de la parole

Pour la première fois, la parole et les expressions faciales ont été synthétisées à partir de signaux cérébraux. Le système a pu décoder ces signaux en texte à près de 80 mots par minute, une grande amélioration par rapport aux 14 mots par minute dictés au clavier virtuel qu'Ann utilise actuellement.La prochaine étape pour l’équipe sera de créer une version sans fil qui ne nécessitera pas qu’Ann soit physiquement connectée à la banque d'ordinateurs.

Le co-premier auteur David Moses, PhD, professeur adjoint en chirurgie neurologique à l'UCSF, affirme :

"Donner à des gens comme Ann la possibilité de contrôler librement leurs propres ordinateurs et téléphones avec cette technologie aurait des effets profonds sur leur indépendance et leurs interactions sociales".

Edward Chang, qui espère que ces travaux conduiront à un système approuvé par la FDA, assure :

"Notre objectif est de rétablir une façon complète et incarnée de communiquer, ce qui est le moyen le plus naturel pour nous de parler avec les autres. Ces progrès nous rapprochent beaucoup plus de la possibilité d’en faire une véritable solution pour les patients".

Sources de l'article : UCSF

L'étude Metzger, S.L., Littlejohn, K.T., Silva, A.B. et coll. "Une neuroprothèse haute performance pour le décodage de la parole et le contrôle des avatars" est parue dans Nature https://doi.org/10.1038/s41586-023-06443-4