Après avoir présenté une méthode de deep learning pour que les modèles d'IA puissent oublier certaines informations et ses travaux en matière de vision par ordinateur et d'apprentissage supervisé, Facebook AI a récemment dévoilé TextStyleBrush, un projet de recherche permettant de remplacer des textes par d'autres, tout en respectant le style et l'apparence de la police d'origine. Les auteurs estiment que l'outil pourrait avoir de nombreuses applications et jetterait les bases de futures innovations comme la traduction linguistique photoréaliste en réalité augmentée.

Le défi d'un modèle d'IA auto-supervisé pour conserver le style d'écriture d'origine

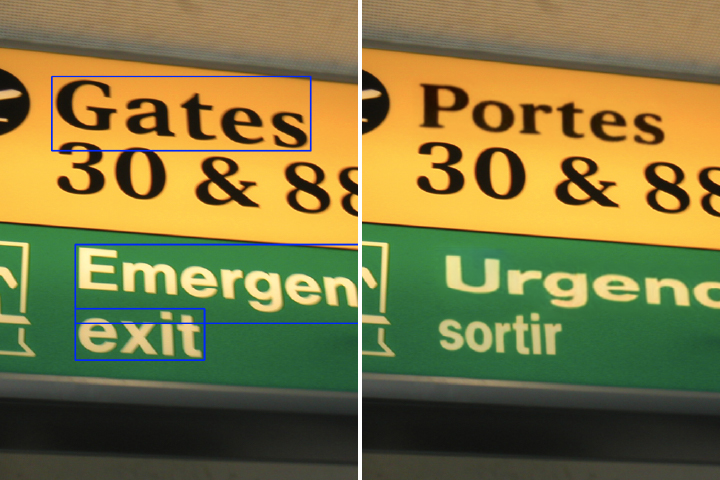

Facebook IA a annoncé la conception d'un modèle d'IA auto-supervisé pouvant conserver le style d'écriture manuscrite ou typographique de son choix, à partir d'un seul mot écrit de cette manière. L'outil peut ainsi reproduire le style d'un mot d'origine et le généraliser en l'appliquant au texte souhaité.Mais l'outil devient plus impressionnant lorsqu'il s'agit de substituer les textes selon le même procédé, en contexte :

Rien en soi que Photoshop ne permette déjà de faire, mais la révolution est dans l'instantanéité, qui ouvre la porte à de nouveaux usages, tels que la traduction automatique en temps réel, à l'image de ce que permet l'application smartphone Google Lens. La différence est dans le réalisme de la substitution. Les applications possibles en matière de réalité augmentée ou de personnalisation à la volée de contenus visuels sont nombreuses. Pour les équipes de Facebook, ce nouveau modèle, basé sur l'apprentissage auto-supervisé se distingue par sa flexibilité.

Les auteurs précisent la difficulté de la tâche :

"Alors que la plupart des systèmes d'IA peuvent le faire pour des tâches bien définies et spécialisées, la construction d'un système d'IA suffisamment flexible pour comprendre les nuances du texte dans les scènes du monde réel et de l'écriture manuscrite est un défi d'IA beaucoup plus difficile."Le modèle fonctionne à la fois avec les écritures manuscrites et typographiques, il est en mesure d'analyser les différentes subtilités de style et prend en compte les transofrmations et déformations telles que rotations et torsions. Les auteurs notent toutefois que des améliorations restent à porter, notamment dans le réalisme des substitutions sur supports metalliques et dans le traitement des reflets.

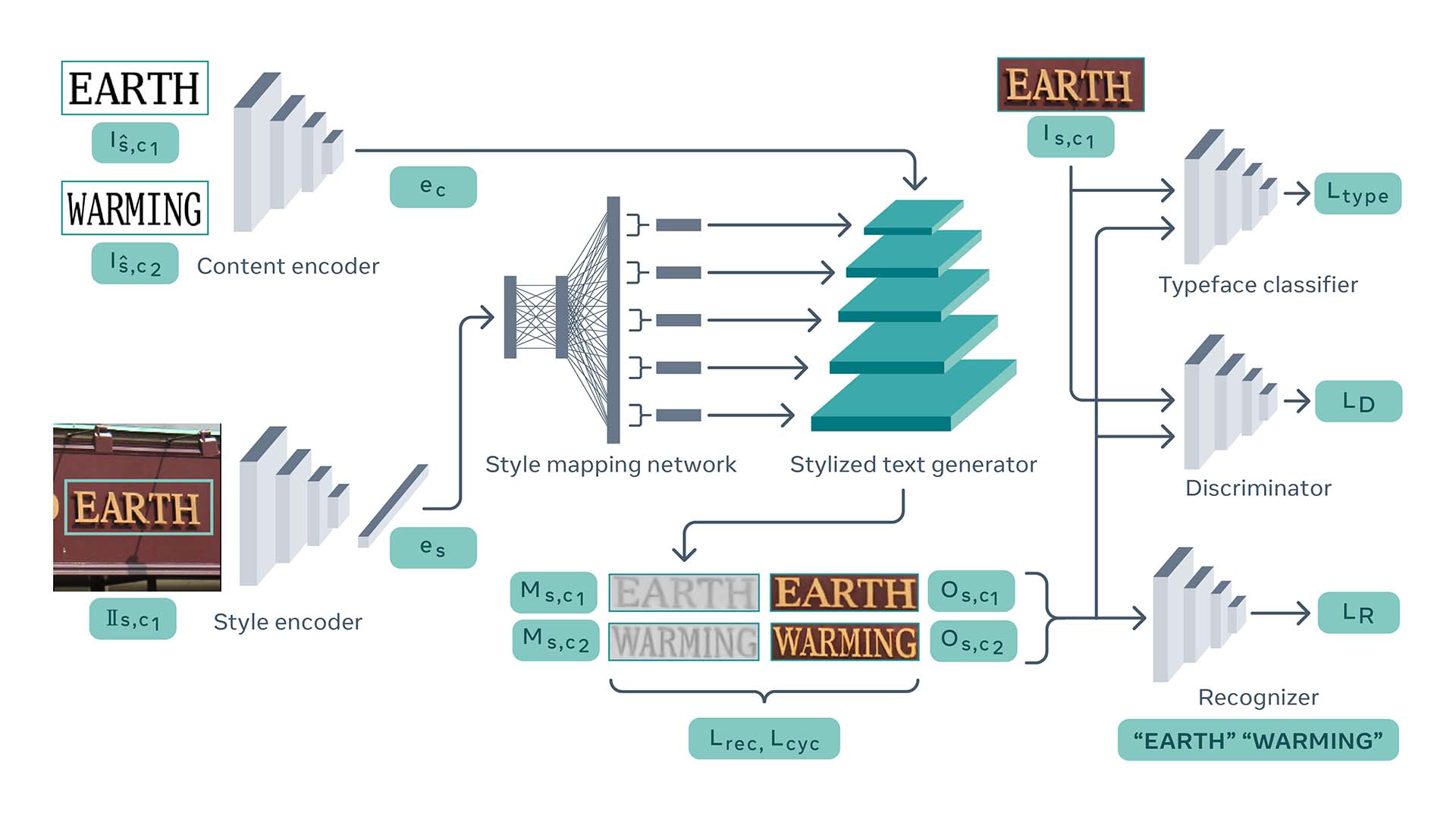

[caption id="attachment_29528" align="aligncenter" width="1920"] Architecture du modèle.[/caption]

Architecture du modèle.[/caption]

L'architecture de générateur est basée sur le modèle StyleGAN2 qui présente toutefois deux notions importantes à prendre en compte :

- StyleGAN2 est un modèle inconditionnel, ce qui signifie qu'il génère des images en échantillonnant un vecteur latent aléatoire alors que les chercheurs doivent contrôler la sortie en fonction de deux sources distinctes proposées par l'utilisateur : le contenu et le style de texte souhaités.

- La représentation des styles de texte implique une combinaison d'informations globales, par exemple, la palette de couleurs et la transformation spatiale, avec des informations détaillées et à petite échelle, comme les variations infimes de la calligraphie individuelle.

Lien vers la publication : https://ai.facebook.com/research/publications/textstylebrush-transfer-of-text-aesthetics-from-a-single-example/