Lors de l’événement Advancing AI 2024, le 10 octobre dernier, Lisa SU a dévoilé les dernières solutions d’AMD conçues pour répondre aux besoins de l’IA à grande échelle dans les entreprises, les centres de données et le cloud. Parmi ces innovations, la 5ème génération de processeurs AMD EPYC, les accélérateurs AMD Instinct MI325X, les processeurs AMD Ryzen AI PRO série 300, ainsi que des solutions réseau de nouvelle génération.

AMD étend les performances de ses accélérateurs

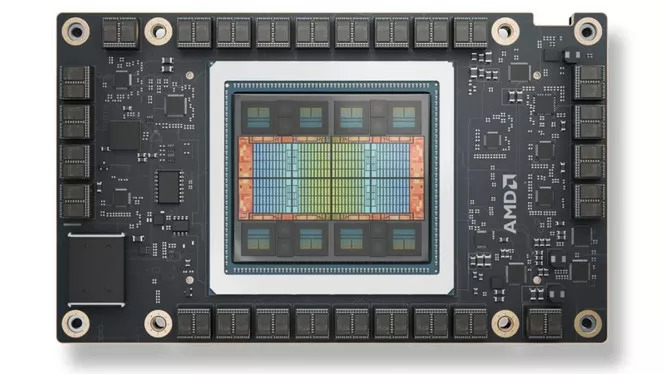

En juin 2023, Lisa Su, PDG d’AMD, dévoilait le GPU Instinct MI300X, conçu pour l’IA générative et le HPC. Selon elle, les AMD Instinct MI325X établissent une nouvelle norme en matière de performances et d’efficacité pour l’entraînement et l’inférence des modèles d’IA générative et les centres de données Gen AI.

Le MI325X utilise la même architecture CDNA 3 que son prédécesseur. Pour la mémoire, AMD opte, comme NVIDIA avant lui avec le H200, pour la HBM3e, une mémoire 50 % plus rapide que la HBM3. Sa capacité étendue à 256 Go de HBM3e supporte un débit de 6,0 To/s, ce qui représente, selon AMD, 1,8 fois plus de capacité et 1,3 fois plus de bande passante que le H200. L’AMD Instinct MI325X offrirait également des performances théoriques en calcul FP16 et FP8 supérieures de 1,3 fois à celles de son concurrent.

Cette mémoire et ce calcul de pointe peuvent fournir, selon la société, jusqu’à 1,3 fois les performances d’inférence sur Mistral 7B à FP16, 1,2 fois les performances d’inférence sur Llama 3.1 70B à FP8, et 1,4 fois les performances d’inférence sur Mixtral 8x7B à FP16, du H200.

Les accélérateurs AMD Instinct MI325X devraient être mis en production ce trimestre et disponibles sur “le système d’un large éventail de fournisseurs de plateformes, notamment Dell Technologies, Eviden, Gigabyte, Hewlett Packard Enterprise, Lenovo, Supermicro et d’autres à partir du 1er trimestre 2025”.

AMD a d’autre part dévoilé en avant-première de nouveaux détails sur la prochaine génération d’accélérateurs AMD Instinct série MI350, qui devraient être disponibles au second trimestre 2025. Basés sur l’architecture AMD CDNA 4 et équipés de jusqu’à 288 Go de mémoire HBM3E, ces accélérateurs offriront une amélioration des performances d’inférence jusqu’à 35 fois supérieure par rapport à leurs prédécesseurs basés sur l’architecture AMD CDNA 3.

AMD a également déclaré avoir fait des progrès significatifs dans le développement des accélérateurs AMD Instinct MI400 Series basés sur l’architecture AMD CDNA Next, dont la disponibilité est prévue en 2026.

Les processeurs EPYC Série 9005

Conçue pour répondre aux exigences croissantes de l’IA et des charges de travail critiques de l’entreprise, la gamme AMD EPYC série 9005 utilise une conception hybride à puces multiples et des cœurs ‘Zen 5’ et ‘Zen 5c’. Elle comprend 29 processeurs différents, variant en termes de nombre de cœurs, de fréquences, de cache et de consommation électrique.

Ils intègrent des fonctionnalités avancées comme la prise en charge de la mémoire DDR5, des canaux PCIe Gen 5, ainsi que des optimisations pour les charges de travail liées à l’IA et au machine learning. Ils offrent également une haute densité de cœurs (jusqu’à 192 cœurs) et une efficacité énergétique améliorée, ce qui les rend idéaux pour les environnements virtualisés et les applications en cloud.

Selon AMD, il est possible de remplacer 100 anciens serveurs à deux sockets équipés de processeurs Intel Xeon 8280 de 28 cœurs par environ 14 nouveaux serveurs à deux sockets équipés de processeurs AMD EPYC 9965 qui comptent 192 cœurs.

La société affirme :

« Avec des chemins de données de 512 bits dans le cœur, des optimisations du pipeline d’instructions et des unités supplémentaires pour les opérations entières et en virgule flottante, le processeur peut exécuter une large gamme de charges de travail IA sur une infrastructure uniquement basée sur CPU, sans nécessiter d’accélération GPU ».

Processeurs AMD Ryzen AI PRO pour les PC d’entreprise

AMD a également présenté les processeurs Ryzen AI PRO série 300, destinés aux PC d’entreprise, intégrant les architectures Zen 5 et AMD XDNA 2, qui équipent les premiers ordinateurs portables Microsoft Copilot+.

Solutions réseau de nouvelle génération

L’entreprise a également élargi son portefeuille de réseaux haute performance pour répondre à l’évolution des exigences de mise en réseau système pour l’infrastructure d’IA avec le réseau frontal AMD Pensando Salina DPU. L’AMD Pensando Pollara 400, première carte réseau compatible avec l’Ultra Ethernet Consortium, conçue pour optimiser le transfert de données au sein des réseaux d’IA back-end pour la communication GPU à GPU, réduit la complexité du réglage des performances et contribue à améliorer le délai de production.

Optimisation des modèles d’IA avec ROCm

AMD continue également d’améliorer sa pile logicielle ROCm : ROCm 6.2 prend désormais en charge des fonctionnalités d’IA critiques telles que le type de données FP8, Flash Attention 3, Kernel Fusion, doublant les performances d’inférence et d’entraînement des LLM sur les accélérateurs AMD Instinct. Aujourd’hui, plus d’un million de modèles IA fonctionnent sur l’architecture AMD, avec une compatibilité sans faille pour les modèles les plus populaires, dont ChatGPT d’OpenAI et Llama de Meta ou les modèles open source de la plateforme Hugging Face.

Lors de l’événement, AMD s’est entouré de partenaires technologiques de premier plan tels que Dell, Google Cloud, HPE, Lenovo, Meta, Microsoft, Oracle Cloud Infrastructure, ainsi que des leaders de l’IA comme Databricks, OpenAI, Cohere, Essential AI, Fireworks AI, Luma AI, et Reka AI pour présenter ses solutions .

Google Cloud et Oracle Cloud Infrastructure ont quant à eux détaillé comment ils exploitent les processeurs EPYC et les accélérateurs Instinct pour développer des capacités de calcul intensif et d’IA générative, tandis que Microsoft a souligné sa collaboration avec AMD pour améliorer les performances de ses infrastructures Azure et GPT grâce aux futurs accélérateurs Instinct MI350.

Lisa Su, PDG d’AMD, affirme :

« Le centre de données et l’IA représentent des opportunités de croissance importantes pour AMD, et nous construisons une forte dynamique pour nos processeurs EPYC et AMD Instinct auprès d’un nombre croissant de clients.

Avec nos nouveaux processeurs EPYC, nos GPU AMD Instinct et nos DPU Pensendo, nous fournissons un calcul de pointe pour alimenter les charges de travail les plus importantes et les plus exigeantes de nos clients. À l’avenir, nous prévoyons que le marché des accélérateurs d’IA pour centres de données atteindra 500 milliards de dollars d’ici 2028. Nous nous engageons à fournir une innovation ouverte à grande échelle grâce à nos solutions étendues de silicium, de logiciels, de réseau et de cluster ».