Officiellement dévoilé en avril dernier, le Wafer Scale Engine V2 (inclus dans le système Cerebras CS-2) est le dernier processeur conçu par l'entreprise Cerebras, un constructeur américain de semi-conducteurs. Toujours dans une volonté d'aller plus loin et de pouvoir mettre en réseau ses processeurs, la firme annonce avoir associé jusqu'à 192 systèmes CS-2. Si une Wafer Scale Engine V2 embarque 850 000 cœurs, cette association si particulière comporte près de 163 millions de cœurs.

Le Wafer Scale Engine V2, la puce aux 850 000 coeurs gravée sur 7 nm

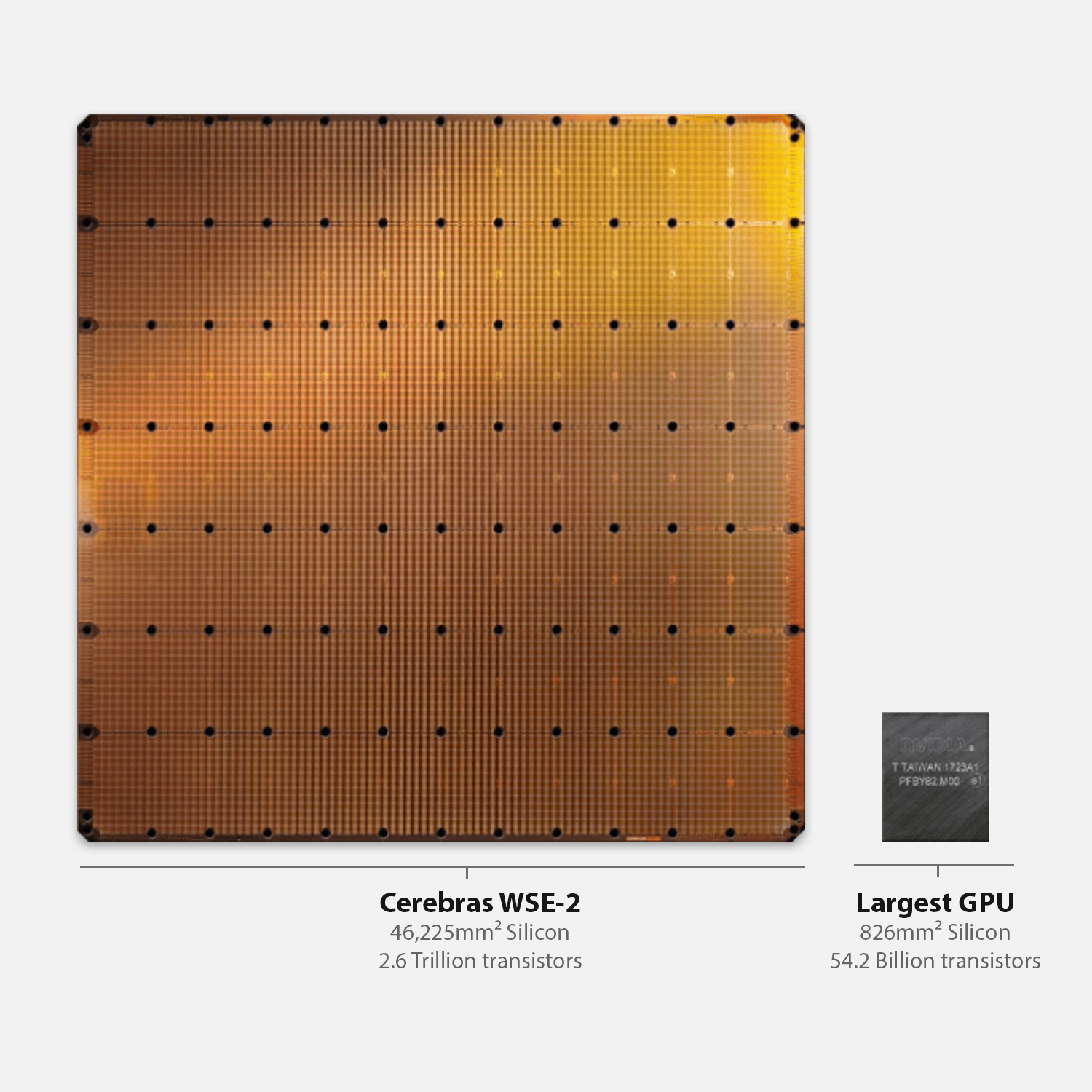

Le Wafer Scale Engine V1 de Cerebras mesurait 46 225 mm2 (soit un carré de 21,5 cm de côté), 1,2 billion (mille milliards) de transistors et 400 000 coeurs. En avril 2021, Cerebras annonce avoir conçu le Wafer Scale Engine V2, avec une gravure de 7 nm, ce qui a permis à l'entreprise, malgré une surface de die identique (21,5 cm x 21,5 cm) d'embarquer 850 000 coeurs et 2,6 billions de transistors.

On retrouve 40 Go de mémoire intégré (SRAM), offre une bande passante mémoire de 20 Po/s et bénéficie d’une interconnexion de 220 Pb/s. Les E/S comprennent 12 ports GbE, soit une bande passante de 1,2 Tb/s. Un seul système engloutit jusqu’à 23 kW. Afin de fonctionner, la société intègre le processeur dans le système Cerebras CS-2 dont on retrouve une illustration ci-dessous :

Pour ce qui est de l'architecture, les cœurs se répartissent sous forme de tuiles, elles-mêmes disséminées au sein d’une multitude de petits dies. Chacune des tuiles a sa mémoire SRAM, son chemin de données FMAC, son propre routeur et son module de contrôle tensoriel. Chacun des cœurs est interconnecté à l'aide d'une matrice 2D.

192 Cerebras CS-2 mis en réseau pour offrir une puissance de calcul sans précédent

Selon Cerebras, un seul système Cerebras CS-2 suffit à une couche d’un réseau neuronal à 120 billions de paramètres (alors que la moyenne tourne autour d’un billion de paramètres). Si elles le souhaitent, les institutions et entreprises pourront créer un énorme supercalculateur puisque le fabricant de semi-conducteurs a réussi à réunir 192 systèmes CS-2 fonctionnant de pair.Cela donne un réseau de 162 millions de coeurs dédiés au calcul à haute performance, ce qui offre une complexité de 120 billions de connexions potentielles. À titre comparatif, notre cerveau se "contente" de 100 billions de connexions synaptiques, soit 20 billions de moins. À noter toutefois que notre cerveau est bien moins gourmand en énergie.

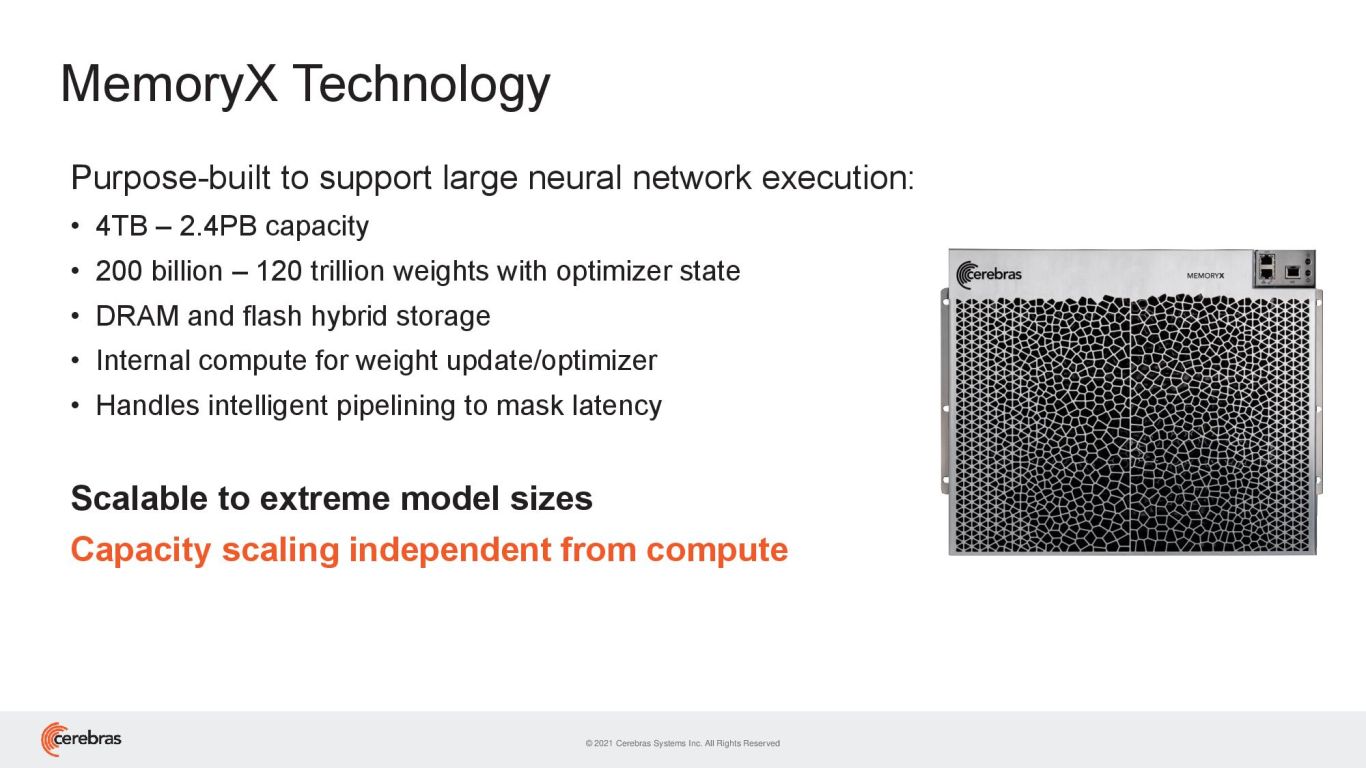

Pour construire un réseau comme celui-ci, Cerebras a bâti un système de parallélisme par distribution de données pour offrir une mise à l'échelle des performances linéaires. Ainsi, les paramètres du modèle sont stockés dans des blocs MemoryX pouvant contenir entre 4 To et 2,4 Po de donnés. Chaque bloc pilote jusqu’à 32 Cerebras CS-2 et intègre de la mémoire RAM et Flash pour conserver les modèles et paramètres hors des processeurs, ce qui permet de libérer la mémoire interne de chaque puce pour exécuter les calculs.

Ce réseau pourrait permettre à des modèles comme GPT-3 d'être entrainés en des temps records alors qu'à l'heure actuelle, plusieurs semaines voire plusieurs mois sont nécessaires.